- RAG 将来自可信数据的检索与 LLM 生成相结合,确保 AI 的回答准确、相关,并且基于真实的企业知识。

- 与纯 LLM 不同,RAG 通过将答案锚定在特定文档、数据库或已批准内容上,减少了幻觉现象。

- RAG 支持获取最新信息,使 AI 系统能够回答有关最新变化或 LLM 静态训练数据之外的细分主题的问题。

- 维护 RAG 系统需要保持数据的时效性、监控输出,并不断优化检索方法,以长期获得最佳性能。

RAG 让企业能够更安全地利用 AI,相比传统 LLM 使用风险更低。

随着越来越多企业引入 AI 解决方案,检索增强生成变得越来越受欢迎。早期的 企业聊天机器人曾出现过高风险错误和幻觉。

RAG 让公司能够利用 LLM 的强大能力,同时将生成的内容牢牢建立在自身的业务知识之上。

什么是检索增强生成?

AI中的检索增强生成(RAG)是一种结合了a)检索相关外部信息和b)AI生成回答的技术,从而提升准确性和相关性。

与单纯依赖大型语言模型(LLM)生成不同,RAG模型的回答基于AI智能体构建者指定的知识库——比如公司网页或人力资源政策文件。

RAG 主要分为两个步骤:

1. 检索

模型会从结构化或非结构化的数据源(如数据库、PDF、HTML 文件或其他文档)中搜索并检索相关数据。这些数据源可以是结构化的(如表格),也可以是非结构化的(如已批准的网站)。

2. 生成

检索到信息后,这些内容会被输入到 LLM 中。LLM 利用这些信息生成自然语言回复,将已批准的数据与自身的语言能力结合,生成准确、类人且符合品牌风格的回答。

RAG 应用场景示例

RAG 的意义是什么?它让企业能够输出相关、有用且准确的内容。

RAG 是降低 LLM 输出不准确或出现幻觉风险的直接方式。

示例一:律师事务所

律师事务所可以在 AI 系统中使用 RAG 来:

- 在研究过程中,从文档数据库中检索相关案例法、判例和法律裁决。

- 通过提取案件文件和过往判决中的关键信息,生成案件摘要。

- 自动为员工提供相关的法规更新。

示例二:房地产中介

房地产中介可以在 AI 系统中使用 RAG 来:

- 总结房产交易历史和社区犯罪统计数据。

- 通过引用本地房产法律法规,解答有关房产交易的法律问题。

- 通过提取房产状况报告、市场趋势和历史销售数据,优化评估流程。

示例三:电商平台

电商企业可以在 AI 系统中使用 RAG 来:

- 从公司数据库收集产品信息、规格和评价,为个性化产品推荐提供依据。

- 检索订单历史,生成符合用户偏好的个性化购物体验。

- 通过检索客户分群数据并结合近期购买行为,生成有针对性的邮件营销活动。

RAG 的优势

任何使用过 ChatGPT 或 Claude 的人都知道,LLM 内置的安全措施非常有限。

如果缺乏适当监管,LLM 可能会生成不准确甚至有害的信息,导致其在实际应用中不可靠。

RAG 通过将回答建立在可信、最新的数据源上,显著降低了这些风险。

防止幻觉和不准确

传统语言模型常常会产生幻觉——即听起来合理但实际上不正确或无关的回答。

RAG 通过依托可靠且高度相关的数据源,有效减少幻觉现象。

检索步骤确保模型引用的是准确、最新的信息,大大降低了幻觉发生的概率,提高了可靠性。

检索最新信息

虽然 LLM 在许多任务中非常强大,但它们无法提供关于罕见或最新信息的准确答案——包括企业专有知识。

而 RAG 可以让模型从任何来源(如网站、表格或数据库)实时获取信息。

这确保了只要数据源持续更新,模型就能给出最新的信息。

支持复杂场景下的交流

传统 LLM 的另一个弱点是容易丢失上下文信息。

LLM 在长对话或复杂对话中难以保持上下文,常常导致回答不完整或内容碎片化。

而 RAG 模型可以通过直接从语义关联的数据源中提取信息,实现对上下文的感知。

针对用户需求提供额外信息——比如配备产品目录的销售聊天机器人——RAG 让 AI 智能体能够参与有上下文的对话。

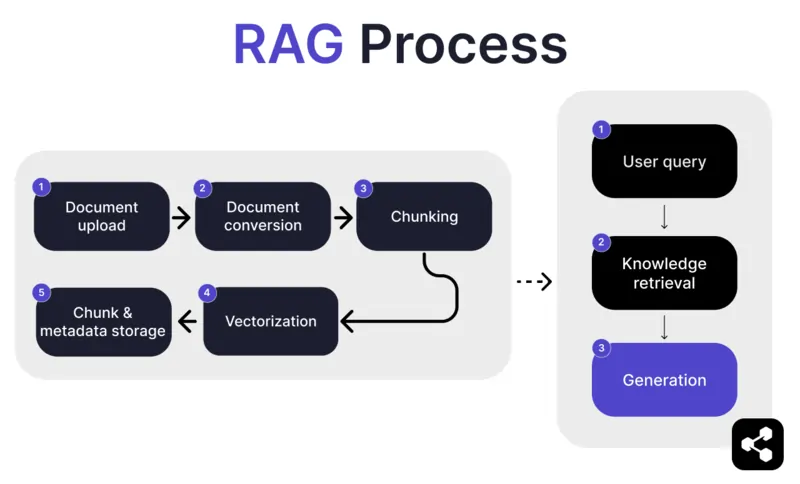

RAG 的工作原理是什么?

1. 文档上传

首先,构建者将文档或文件上传到其 AI 智能体的资料库。文件可以是网页、PDF 或其他支持的格式,这些内容将成为 AI 的知识基础。

2. 文档转换

由于文件类型多样(如 PDF、网页等),系统会将这些文件转换为标准化的文本格式,便于 AI 处理和检索相关信息。

3. 分块与存储

转换后的文档会被拆分成更小、更易管理的片段(chunk)。这些片段被存储在数据库中,便于 AI 智能体在查询时高效检索相关内容。

4. 用户提问

知识库搭建完成后,用户可以向 AI 智能体提问。系统会利用 自然语言处理(NLP) 理解用户的问题。

5. 知识检索

AI 智能体会在存储的片段中搜索,利用检索算法找到最能回答用户问题的相关信息。

6. 生成回答

最后,AI 智能体会将检索到的信息与自身的语言模型能力结合,根据提问和检索数据生成连贯、上下文准确的回答。

高级 RAG 功能

如果你不是开发者,可能会惊讶地发现,并非所有 RAG 都是一样的。

不同系统会根据需求、应用场景或技术能力,构建不同的 RAG 模型。

有些 AI 平台还会提供高级 RAG 功能,进一步提升 AI 软件的准确性和可靠性。

语义分块 vs 机械分块

机械分块是指将文档按固定大小切分,比如每 500 字为一段,不考虑内容含义或上下文。

而语义分块则根据内容将文档拆分为有意义的部分。

它会考虑自然断点,如段落或主题,确保每个片段都包含连贯的信息。

强制引用

对于金融、医疗等高风险行业,自动化对话时引用来源有助于提升用户对信息的信任度。

开发者可以要求 RAG 模型为所有输出信息提供引用。

例如,员工向 AI 聊天机器人咨询健康福利信息时,机器人可以回复并附上相关员工福利文件的链接。

构建自定义 RAG AI 智能体

将最新 LLM 的强大能力与你独特的企业知识结合。

Botpress 是一个灵活且高度可扩展的 AI 聊天机器人平台。

它允许用户为任何场景构建各种类型的 AI 智能体或聊天机器人,并且提供业界最先进的 RAG 系统。

将你的聊天机器人集成到任意平台或渠道,或从我们的预置集成库中选择。你可以通过Botpress YouTube频道的教程或Botpress Academy的免费课程快速入门。

立即开始构建。 免费使用。

常见问题

1. RAG 与微调 LLM 有什么不同?

RAG(检索增强生成)与微调不同,因为RAG保持原始大语言模型(LLM)不变,并在运行时通过检索相关文档注入外部知识。微调则是利用训练数据修改模型权重,需要更多的计算资源,并且每次更新都必须重新进行。

2. 哪些类型的数据源不适合用于RAG?

不适合RAG的数据源包括非文本格式,如扫描文档、基于图片的PDF、没有转录的音频文件,以及过时或内容相互矛盾的数据。这些类型的数据会降低检索上下文的准确性。

3. RAG与提示工程等上下文学习技术相比有何不同?

RAG与提示工程不同,它在查询时从大型已建立索引的知识库中检索相关内容,而不是依赖于提示中静态、手动嵌入的示例。这使得RAG更易扩展,并且能够在无需重新训练的情况下保持知识的最新性。

4. 我可以将RAG与第三方大语言模型(如OpenAI、Anthropic或Mistral)一起使用吗?

可以,您可以通过独立处理检索流程,并将检索到的上下文通过API发送给OpenAI、Anthropic、Mistral等LLM。只要LLM支持通过提示接收上下文输入,RAG就可以与任何模型配合使用。

5. 启用RAG的AI智能体需要怎样的持续维护?

启用RAG的AI智能体的持续维护包括:用新文档或修正后的文档更新知识库,定期重新建立索引,评估检索质量,调整分块大小和嵌入方法,并监控智能体的回复以防止偏离或幻觉问题。

.webp)