- AI幻觉是指模型自信地产生错误或虚构的信息,通常由数据质量差、过拟合或提示不明确引起。

- 幻觉可能表现为事实错误或捏造内容,可能破坏信任、让企业损失数十亿美元,或传播有害虚假信息。

- 主要预防措施包括选择可靠的AI平台、引入检索增强生成(RAG)、设计精确的提示,并加入人工监督。

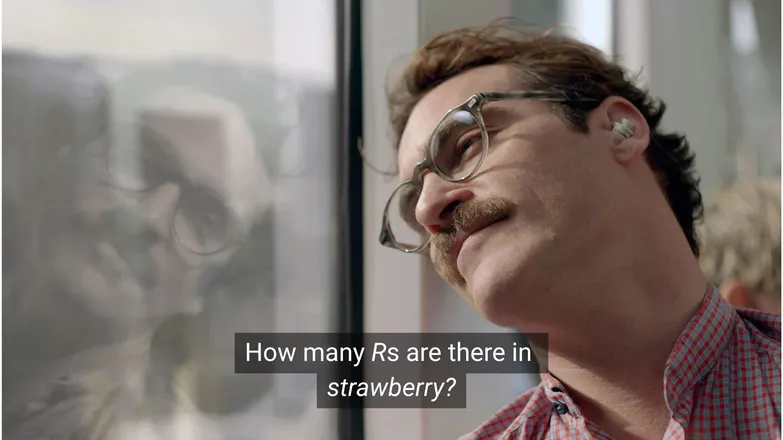

你觉得如果华金·菲尼克斯问斯嘉丽·约翰逊“strawberry”里有几个R,他还会爱上她吗?如果你用过LinkedIn,你就知道答案是3。(或者说,如果你会读的话。)

但对AI聊天机器人来说,事情并不总是这么简单。

你可能见过有人拿AI幻觉的荒谬开玩笑。说实话,一个看似无所不知、推理能力接近人类、执行任务飞快的AI模型,却连幼儿园水平的数学题都答错,确实挺荒唐的。

但在这些玩笑背后,隐藏着更严肃、甚至潜在危险的现实。

本文将介绍AI幻觉——它是什么、成因、影响,以及你可以采取哪些措施来预防。

什么是AI幻觉?

AI幻觉是指AI模型给出不准确、误导性或完全虚构的信息。这些虚假信息看起来很可信,很多时候难以被察觉。

由于大语言模型(LLM)的广泛应用,幻觉通常是在生成式文本模型的语境下讨论的。实际上,任何生成式AI的应用都存在这种风险。

AI幻觉的成因有哪些?

AI幻觉发生在模型学到了错误的模式时。

模式,在AI语境下,指的是模型利用单个训练样本去泛化到未见过的数据的能力。这可以是一系列单词组成文本的延续,也可以是图像像素的分布,比如识别一只狗。

在LLM幻觉的情况下,模型认为某些词序列是用户提示后最有可能出现的内容,尽管它其实是错误的。

这可能由以下一种或多种原因造成:

训练数据质量低

ChatGPT等LLM模型训练时用到了大量数据。尽管数据量很大,但由于以下原因并不完美:

- 某些话题存在空白

- 反映现实世界的偏见

- 包含故意虚假信息或未标记的讽刺内容

- 数据偏斜,即数据分布不均衡。

假设模型训练时涵盖了所有希腊神祇,唯独漏掉了一个。

它在希腊神话相关主题——比如爱情、伦理、背叛——之间建立统计联系时,可能会凭借统计模型“编造”出貌似合理的神话故事。

在图像生成中也有类似现象,比如大多数女性主题的提示会生成过度性化的图片。对某种特定表现形式的偏见会影响生成的图片类型。

strawberry的拼写很可能在训练数据中与讨论双R相关,这是非母语英语者的常见难点。在这种情况下,数字2或“double”这个词很可能会与拼写相关联。

另一方面,数据中很少会提到它有3个R。

输出之所以荒谬,是因为提示本身就很奇怪:什么情况下会有人写出一个单词后再问怎么拼?

模型架构与生成方式

这些模型基于极其复杂的神经网络架构构建。细微差别会影响模型如何处理训练数据和输入提示。模型减少幻觉的能力依赖于持续的渐进式改进,需要大量研究和测试。

此外,生成方式也有影响。模型是逐词(实际上是词片)预测下一个最可能的词。因此:

“The quick brown fox jumps over the lazy ___.”

模型会判断下一个最可能的词是“dog”。但其他词也有可能。如果只根据最可能的下一个词生成,结果会很无聊、可预测。

这意味着需要采用更具创造性的采样方法,让回复既有趣又连贯。但这样一来,事实准确性有时就会被忽略。

过拟合

过拟合是指模型对训练数据拟合得过于紧密,导致无法泛化到新输入。

所以,如果我是个模型(我妈说我应该是),那么如果我能识别狗是:

毛茸茸的、耳朵下垂、爱玩,还有一个棕色的小鼻子。

但如果我只认得:

下巴有个棕色斑点、名字叫“Frank”、还把我那双好耐克鞋咬烂了,那我就是过拟合了。

在LLM语境下,过拟合通常表现为机械复述训练数据中的内容,而不是在不确定时选择不回答。

比如你问聊天机器人某公司的退货政策。如果它不知道,应该直接告诉你。但如果过拟合了,它可能会给出另一家类似公司的政策。

提示不佳

许多公司正在发放提示工程证书,因为AI的表现取决于输入质量。

一个好的提示表达清晰,避免使用小众术语,并提供所有必要的上下文。

这是因为幻觉往往发生在许多低概率输出的边缘。

比如你问“shark girl的剧情是什么?”人类会想“嗯,shark girl。”在统计学上,可能性有:

- 鲨鱼男孩与熔岩女孩历险记——2005年一部很有名的儿童电影,名字相近。

- 2024年一部叫Shark Girl的惊悚/恐怖片——知名度较低但更新、更准确。

- 同名儿童读物——今年早些时候出版,模型可能有也可能没有收录。

这些都不是显而易见的选择,导致概率分布“更平”,模型对某一主题或叙述的确定性降低。更有效的提示应该提供上下文,也就是明确用户指的是哪一个例子。

这种模糊和相关性不强的混合,可能导致模型编造出一个与鲨鱼相关的通用剧情。

降低幻觉发生概率,就是降低不确定性。

AI幻觉的类型

目前为止,我都是泛泛而谈幻觉。实际上,它几乎影响AI的所有方面。为了更清晰,最好区分不同类型。

事实性错误

这就是strawberry例子的情况。即在本来正确的陈述中出现细节错误,比如某事件发生的年份、某国首都、某项统计数字等。

在总体回答不错的情况下,细节错误尤其隐蔽,特别是涉及人类不常记住的内容,比如具体数字。

虚构内容

2023年,谷歌的Bard错误声称詹姆斯·韦布望远镜用于拍摄第一张系外行星照片。这不仅仅是技术性错误——而是彻头彻尾的虚假信息。

这些可能像上面那样是大胆的断言,但更多时候表现为无效的链接,或是凭空捏造的代码库和函数。

值得注意的是,事实性错误与虚构内容之间的界限并不总是清晰的。

比如我们在讨论一位研究人员。如果我们引用了他们的一篇论文但年份弄错了,这是事实性错误。如果名字错了呢?如果名字和年份都错了又该如何?

错误信息

这可能属于前面两类中的任何一种,但特指信息来源较为透明的虚假内容。

谷歌AI著名的推荐胶水披萨和吃石头就是一个很好的例子;其来源显然是讽刺且基本无害——比如The Onion在Reddit上的评论,但模型训练时并未考虑到这一点。

AI幻觉的风险

1. 信任丧失

我们乐于将任务交给AI处理,但不能以牺牲信任为代价。

Cursor AI最近发生的事故——客服机器人凭空编造了一个限制性政策——导致许多用户取消了订阅,质疑其可靠性。

2. 成本

AI已成为许多企业的核心驱动力,这本是好事,但一旦出错,代价可能非常高昂。

谷歌的詹姆斯·韦布幻觉事件导致Alphabet股价在短短几小时内蒸发了1000亿美元。这还不包括重新训练模型的成本。

3. 有害的错误信息

我们会对胶水披萨的荒谬感到好笑,但如果是误导性的药物剂量呢?

我当然愿意用AI的快速答案来替代那些充满警告的小字说明。但如果答案错了怎么办?它几乎肯定无法涵盖所有可能的医疗状况。

3. 安全与恶意软件

如前所述,AI经常凭空捏造代码库名称。当你尝试安装一个不存在的库时,什么都不会发生。

现在想象一下,黑客将恶意软件嵌入代码中,并以常见的“幻觉”库名称上传。你安装了这个库,💨瞬间💨:你被黑了。

这种现象确实存在,被称为slopsquatting。

抛开这个名字不谈,安装任何东西时保持批判性思维、对那些听起来奇怪的库名称进行二次核查总是没错的。

防止AI幻觉的措施

如果你不是在训练模型,那么在数据和架构层面你能做的很有限。

好消息是,你仍然可以采取一些预防措施,这些措施对于打造无幻觉的AI至关重要。

选择值得信赖的模型和平台

你并不是孤军奋战。AI公司非常重视维护用户信任,这意味着要杜绝幻觉。

根据你在AI上的具体应用,通常至少有几种选择,一个优秀的AI平台会让这些选择变得易于获取。这些平台应当对他们如何减少幻觉保持透明。

使用RAG(检索增强生成)

不要让模型只依赖自身知识。为你的模型配备RAG,可以明确地提供信息来源和获取方式。

最好在一个平台上运行AI,该平台能提供如何高效实现RAG的简单说明。

添加详细的指令

你一定听过无数次:输入垃圾,输出垃圾。

“回答用户问题”并不能保证成功。但像这样:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.能让你的智能体保持规范。清晰的提示和严格的规则是防止智能体失控的最佳防线。

人工核查

说到升级处理,最好有专人随时准备检查、评估并解决AI的不足。

具备升级处理或事后核查对话的能力,可以帮助你发现有效之处和潜在幻觉风险。人类参与——即对AI驱动流程进行人工监督——在这里必不可少。

立即使用无幻觉AI

对AI可靠性的担忧可能让企业迟迟不敢进行数字化转型。

Botpress的RAG能力、人类参与集成以及完善的安全体系,让AI既安全又可靠。你的智能体为你工作,而不是相反。

立即开始构建。永久免费。

常见问题

1. 如果我对某个话题不了解,如何判断AI的回答是不是幻觉?

如果你对某个话题没有先验知识,可以通过以下迹象判断AI回答是否为幻觉:极为具体的断言、过于自信的语气,或无法独立验证的名称、数据或引用。当不确定时,可以要求AI注明信息来源,或与可靠的外部资料进行交叉核查。

2. 大型语言模型(LLM)中AI幻觉有多常见?

AI幻觉在大型语言模型中很常见,因为它们生成文本依赖概率而非事实核查。即使是GPT-4o和Claude 3.5等先进模型,在被问及冷门话题或上下文不足时,也可能输出不准确的内容。

3. 非文本类AI模型(如图像生成器)也会出现幻觉吗?

会的,图像生成模型也会出现幻觉,通常表现为输出中不现实或荒谬的元素——比如多余的肢体或错误的文化表现——这些都是训练数据偏差或缺失造成的。

4. 由于训练数据偏差,某些语言或文化背景下的幻觉更常见吗?

在代表性不足的语言或非西方文化语境下,幻觉更为常见,因为大多数LLM主要以英语和西方数据为训练基础,导致对其他文化的回应缺乏细致性。

5. 哪些行业最容易受到AI幻觉带来的风险?

医疗、金融、法律和客户服务等行业最容易受到AI幻觉的影响,因为这些领域的不准确信息可能导致合规违规、经济损失、法律失误,或损害用户信任和品牌声誉。

.webp)