- AI 幻覺是指模型自信地產生錯誤或虛構資訊,通常由於資料品質不佳、過度擬合或提示不明確所導致。

- 幻覺可能從事實錯誤到捏造內容不等,這會損害信任、讓企業損失數十億,甚至散播有害的錯誤資訊。

- 預防的關鍵步驟包括選擇可靠的 AI 平台、加入檢索增強生成(RAG)、撰寫精確的提示,以及納入人工審核。

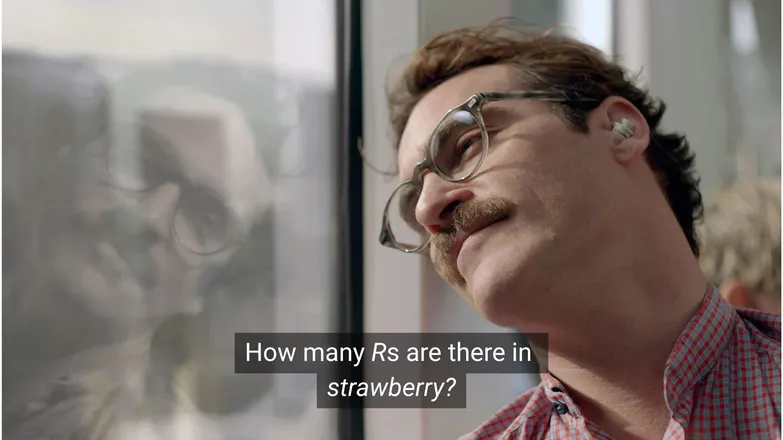

你覺得如果 Joaquin Phoenix 問 Scarlett Johansson 「strawberry」裡有幾個 R,他還會愛上她嗎?如果你有在 LinkedIn 上,應該知道答案是 3。(或者說,只要你會讀字。)

但對 AI 聊天機器人 來說,事情可沒那麼簡單。

你大概看過有人嘲笑 AI 幻覺的荒謬。說實話,一個看似知識無窮、推理能力近似人類、執行任務又快如閃電的 AI 模型,卻連幼稚園等級的數學題都會錯,確實有點荒謬。

但在這些趣味背後,隱藏著更嚴肅、甚至潛在危險的現實。

本文將談談 AI 幻覺——它是什麼、成因、為什麼重要,以及你可以採取哪些預防措施。

什麼是 AI 幻覺?

AI 幻覺是指 AI 模型呈現出不正確、誤導或完全虛構的資訊。這些錯誤資訊看起來很合理,很多時候甚至不易被察覺。

由於 LLM 被廣泛應用,幻覺最常在生成式文字模型的情境下被提及。事實上,任何 生成式 AI 的應用 都有這種風險。

AI 為什麼會產生幻覺?

AI 幻覺發生在模型學習到錯誤的模式時。

模式,在 AI 的語境下,是指模型能利用單一訓練範例,泛化到未見過的資料。例如一連串文字組成文本的延續,或是影像像素的分布對應到一隻狗。

在 LLM 幻覺的情況下,模型認為某些詞語是使用者提示下最可能的接續,儘管事實上是錯的。

這可能是由以下一個或多個原因造成:

訓練資料品質低落

ChatGPT 和類似的 LLM 以大量資料訓練。這些資料雖然龐大,但仍有缺陷,原因包括:

- 某些主題存在缺口

- 反映現實世界的偏見

- 刻意的錯誤資訊或未標示的諷刺

- 偏頗,也就是資料不均或「失衡」。

想像一個情境,模型訓練時學到所有希臘神祇的資訊,唯獨漏掉一位。

它在希臘神話相關主題——愛情、倫理、背叛——之間建立統計連結時,可能會編造出一段它認為「合理」的神話故事。

這在影像生成也很明顯,例如大多數女性主題的提示會產生過度性感化的圖像。這種偏見對某種特定描繪方式的制約,會影響生成的圖像類型。

strawberry 的拼法很可能在訓練資料中,與討論雙 R 有關,這是非英語母語者常見的痛點。在這種情境下,數字 2 或「double」這個詞,常會和這個單字的拼法一起出現。

反過來說,資料中很少會提到它有 3 個 R。

這個回答之所以荒謬,是因為提示本身就很奇怪:什麼情況下會有人寫出一個單字,然後再問怎麼拼?

模型架構與生成方式

這些模型是由極其複雜的 神經網路架構所建構。細微的差異會影響模型如何與訓練資料和輸入提示互動。模型減少幻覺的能力,需透過嚴謹的研究與測試來逐步改進。

此外,生成的實作方式也很重要。模型會逐字(實際上是 詞片段)預測最有可能的下一個詞。所以:

「The quick brown fox jumps over the lazy ___。」

模型會判斷「dog」是最有可能的下一個詞。但其他詞也有可能出現。如果只根據最可能的下一個詞來生成,結果會很無聊、太可預測。

這表示必須採用更有創意的取樣方法,讓回應既有趣又連貫。但這樣一來,正確性有時就會被犧牲。

過度擬合

過度擬合是指模型訓練時過度貼合資料,導致無法泛化到新輸入。

所以,如果我是個模型(我媽說我應該當),那我如果能認出狗是:

毛茸茸、耳朵下垂、愛玩、還有一個小小的棕色鼻子,那就算訓練得不錯。

但如果我只認得:

下巴有個棕色點、名字叫「Frank」、還把我那雙好球鞋咬爛了,那就是過度擬合。

在 LLM 的情境下,通常表現為只會重複訓練資料裡看過的資訊,而不是在不知道答案時選擇不回答。

比如你問聊天機器人某公司的退貨政策。如果它不知道,應該要告訴你。但如果過度擬合,它可能會回傳另一家類似公司的政策。

提示設計不良

許多公司開始發放提示工程證書,因為大家都知道 AI 的表現取決於輸入內容。

一個好的提示要明確表達、避免冷僻術語,並提供所有必要的背景資訊。

這是因為幻覺常發生在許多低機率輸出之間的邊緣地帶。

假設你問「shark girl 的劇情是什麼?」人類會想:「嗯,shark girl。」在統計世界裡,可能性有:

- 鯊魚男孩與熔岩女孩歷險記——2005 年一部很有名的兒童電影,名字很像。

- 2024 年的驚悚片《Shark Girl》——比較新但沒那麼有名,卻比較精確。

- 同名兒童繪本,今年初出版——模型可能有收錄,也可能沒有。

這些都不是明顯的選項,導致機率分布「較平」,模型對主題或敘事沒有明確傾向。更有效的提示應該提供背景,也就是明確說明用戶指的是哪一個例子。

這種模糊與邊緣相關的混合,可能產生一個完全虛構、泛泛而談的鯊魚故事劇情。

降低幻覺發生率,就是降低不確定性。

AI 幻覺的類型

目前為止,我談的都是幻覺的概念。事實上,這幾乎涵蓋了 AI 的所有面向。為了說明清楚,最好還是分門別類來看。

事實錯誤

這就是 strawberry 例子所屬的類型。也就是在本來正確的陳述中,細節出現錯誤。像是某事件發生的年份、一個國家的首都,或統計數字等。

在其他方面都正確的回應中,細節錯誤尤其難以察覺,特別是那些人類不常記得的細節,例如精確數字。

虛構內容

2023 年,Google 的 Bard 錯誤宣稱詹姆斯·韋伯太空望遠鏡拍攝了第一張系外行星的照片。這不只是技術性錯誤——而是完全錯誤的資訊。

這些錯誤有時像上述那樣大膽,但更多時候則表現為無效的網址,或是虛構的程式庫和函式名稱。

值得注意的是,事實錯誤與虛構內容之間的界線並不總是那麼明確。

假設我們正在討論一位研究人員。如果我們引用了他的論文但年份寫錯,這是事實錯誤。如果名字寫錯呢?那如果名字和年份都錯了呢?

錯誤資訊

這可能屬於前述兩種情況之一,但特指來源較為明確的錯誤資訊。

Google AI 著名的例子是建議在披薩上塗膠水、吃石頭;這些內容明顯來自惡搞、無害的來源——例如由 The Onion 撰寫的 Reddit 留言,但模型訓練時並未將這些納入考量。

AI 幻覺的風險

1. 失去信任

我們樂於將任務交給 AI 處理,但不能因此犧牲對它的信任。

Cursor AI 最近發生的意外——客服機器人捏造了一項限制性政策——導致許多用戶取消訂閱,質疑其可靠性。

2. 成本

AI 已成為許多企業的核心,雖然這是好事,但一旦出錯,代價可能非常高昂。

Google 關於詹姆斯·韋伯的幻覺事件,導致 Alphabet 股價在幾小時內蒸發了 1,000 億美元。這還不包括重新訓練模型的成本。

3. 有害的錯誤資訊

我們會對膠水披薩的荒謬感到好笑,但如果是誤導性的藥物劑量呢?

我會第一個選擇用 AI 快速查詢答案,而不是閱讀滿是警語的小字。但如果答案是錯的呢?AI 幾乎不可能考慮到所有潛在的醫療狀況。

3. 資安與惡意軟體

如前所述,AI 經常虛構程式庫名稱。當你嘗試安裝不存在的程式庫時,什麼事都不會發生。

但想像一下,駭客將惡意軟體植入程式碼,並以上述常被虛構的程式庫名稱上傳。你安裝了這個程式庫,然後💨瞬間💨:你被駭了。

這種攻擊方式確實存在,稱為slopsquatting。

撇開這個名稱不談,對於你安裝的東西保持批判態度、仔細檢查那些聽起來奇怪的程式庫名稱,永遠不嫌多。

預防 AI 幻覺的步驟

如果你不是在訓練模型,對於資料和架構端能做的其實有限。

好消息是,你仍然可以採取一些預防措施,這些措施對於打造無幻覺的 AI 至關重要。

選擇值得信賴的模型與平台

你並不是孤軍奮戰。AI 公司非常重視維護用戶信任,這也代表不能出現幻覺。

根據你使用 AI 的情境,通常會有幾種選擇,而好的AI 平台會讓這些選擇變得容易。這些平台應該要公開他們如何減少幻覺的方式。

使用 RAG(檢索增強生成)

不要讓模型只依賴自身知識。為你的模型配備RAG,可以明確知道資訊來源與取得方式。

最好選擇有簡單教學說明如何有效實作 RAG的平台來運行 AI。

加入詳細指示

這句話你一定聽過無數次:垃圾進,垃圾出。

「回答用戶問題」並不能保證成功。不過,像這樣的指示:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.能讓你的代理人保持在正軌。明確的提示與嚴謹的規範,是防止 AI 失控的最佳防線。

人工驗證

談到升級處理,讓人員隨時準備檢查、評估並修正 AI 的不足。

能夠升級處理,或事後驗證對話,讓你能找出有效之處與潛在幻覺風險。人機協作——人工監督 AI 流程——在這裡不可或缺。

立即使用無幻覺的 AI

對 AI 可靠性的疑慮,可能讓企業遲遲不敢數位轉型。

Botpress 的 RAG 能力、人機協作整合,以及完善的資安系統,讓 AI 安全又可靠。你的代理人為你工作,而不是反過來。

立即開始打造。免費使用。

常見問題

1. 如果我對主題沒有先備知識,該如何判斷 AI 回答是否為幻覺?

若沒有先備知識,判斷 AI 回答是否為幻覺,可以觀察是否有極為具體的主張、過度自信的語氣,或是無法獨立查證的名稱、統計數據或引用。若有疑慮,可要求 AI 提供來源,或與可靠的外部資料交叉比對。

2. 大型語言模型(LLM)中的 AI 幻覺有多常見?

AI 幻覺在大型語言模型中很常見,因為這些模型是根據機率生成文字,而不是事實驗證。即使是 GPT-4o、Claude 3.5 這類先進模型,在被問及冷門主題或資訊不足時,也可能產生不正確的內容。

3. 非文字型 AI 模型(如圖像生成器)也會出現幻覺嗎?

會,圖像生成模型也會出現幻覺,常見於輸出中出現不合理或無意義的元素——例如多出來的肢體或錯誤的文化表現——這通常是訓練資料偏誤或不足所致。

4. 由於訓練資料偏誤,幻覺在某些語言或文化中更常見嗎?

在資料較少的語言或非西方文化情境下,幻覺更常見,因為大多數 LLM 主要以英文和西方資料訓練,導致回應較缺乏文化細緻度。

5. 哪些產業最容易受到 AI 幻覺的影響?

醫療、金融、法律和客服等產業最容易受到 AI 幻覺的影響,因為這些領域若出現錯誤資訊,可能導致法規違規、財務損失、法律糾紛,或損害用戶信任與品牌聲譽。

.webp)