- Ginagabayan ng chain-of-thought prompting ang mga AI model na mag-isip nang sunud-sunod, kaya mas mahusay nilang nalulutas ang mahihirap na gawain kaysa basta hulaan lang ang susunod na salita.

- Pinakamainam itong gamitin sa mga problemang may maraming hakbang, tulad ng matematika, palaisipan sa lohika, o mga prosesong gawain, ngunit hindi kailangan para sa mga simpleng tanong na factual o may isang hakbang lang.

- Iba ang prompt chaining sa chain-of-thought prompting dahil hinahati nito ang gawain sa maraming magkakahiwalay na prompt, samantalang ang chain-of-thought ay nananatili sa isang prompt-response na daloy.

Kung gumamit ka na ng GPT chatbot gaya ng ChatGPT, malamang napansin mo na pabago-bago ang kalidad ng mga sagot nito.

Minsan, eksakto ang sagot na kailangan mo. Minsan naman, parang nakakaduda kung may ‘intelligence’ nga ba talaga ang AI.

Mapapahusay mo pa ang paggamit mo ng ChatGPT sa pamamagitan ng mas maayos na pag-prompt dito. Hinihikayat ng chain-of-thought prompting ang mga LLM agent na mag-isip nang sunud-sunod sa bawat hakbang bago bumuo ng sagot.

Ang mga mas bagong AI model at features ay nagsisimula nang magtampok ng chain-of-thought reasoning mismo, kaya awtomatikong nag-iisip ang mga ito sa problema kahit walang dagdag na prompt.

Ano ang chain-of-thought prompting?

Ang chain-of-thought prompting ay isang teknik sa prompt engineering sa AI na nagtuturo sa mga model na hatiin ang mahihirap na gawain at mag-isip sa bawat hakbang bago sumagot.

Maaari mo ring marinig ang terminong ‘chain-of-thought reasoning’. Tumutukoy ito sa sunud-sunod na proseso ng pag-iisip ng model para lutasin ang isang gawain.

Hindi na kailangan ng chain-of-thought prompting sa mga OpenAI o1 models dahil mayroon na silang built-in na chain-of-thought reasoning. Pero maaari mo pa ring gamitin ang chain-of-thought prompting sa anumang chatbot na pinapagana ng LLM.

Paano gumagana ang chain-of-thought reasoning?

Ang chain-of-thought reasoning ay paghahati-hati ng isang problema sa mas maliliit at lohikal na mga hakbang na lulutasin ng AI chatbot nang sunud-sunod.

Una, tinutukoy ng AI ang mahahalagang bahagi ng problema. Pagkatapos, pinoproseso nito ang bawat bahagi nang sunud-sunod, iniisip kung paano nauugnay ang bawat hakbang sa susunod. Bawat hakbang ay nakabatay sa nauna, kaya sistematikong nakakarating ang AI sa lohikal na konklusyon.

Mga halimbawa ng chain-of-thought prompting

Ang sikat na ‘strawberry’ prompt

May mga kilalang kahinaan ang ChatGPT at iba pang LLMs. Isa na rito ang hindi nila tamang matukoy kung ilang 'R' ang nasa salitang ‘strawberry’. (Malamang ito rin ang dahilan ng code name na Strawberry ng o1 models.)

Hindi gumagamit ng chain-of-thought reasoning ang ChatGPT-4o. Sa halip, umaasa ito sa training data at bumubuo ng sagot base sa posibilidad ng bawat salitang kasunod ng nauna. Kahit madalas tama ang tunog ng sagot, ginagaya lang nito ang wika ng tao—hindi talaga nag-iisip o nagsasaliksik.

Kapag tinanong mo ang ChatGPT-4o ng sikat na strawberry na tanong, hindi nito naibibigay ang tamang sagot:

Gayunpaman, maaari mong gamitin ang paraang chain-of-thought prompting upang matulungan ang chatbot na pinapagana ng LLM na makuha ang tamang sagot:

Ang pinakabagong bersyon ng ChatGPT, gamit ang OpenAI o1-preview, ang unang malaking LLM na gumagamit ng chain-of-thought reasoning nang hindi na kailangan ng dagdag na prompt.

Tama agad ang sagot nito sa unang subok, dahil inutusan na itong awtomatikong sundan ang parehong proseso tulad ng ikalawang prompt sa ChatGPT-4o sa itaas. Ang kaibahan lang, ginagawa na ito ng model nang kusa.

Matematika

Kung tatanungin mo ang mas lumang bersyon ng ChatGPT ng tanong sa matematika mula sa elementarya, hindi ito palaging tama ang sagot.

Kailangan ng lohikal na pag-iisip sa mga problemang may maraming hakbang, na wala sa mga naunang LLM. Maaari mong hatiin ang bawat hakbang ng problema, pero kung hindi mo alam ang tamang proseso, hindi rin makakatulong ang LLM.

Kaya ng ChatGPT-4o na alamin ang sagot sa pamamagitan ng paghahati-hati ng mga hakbang sa problema:

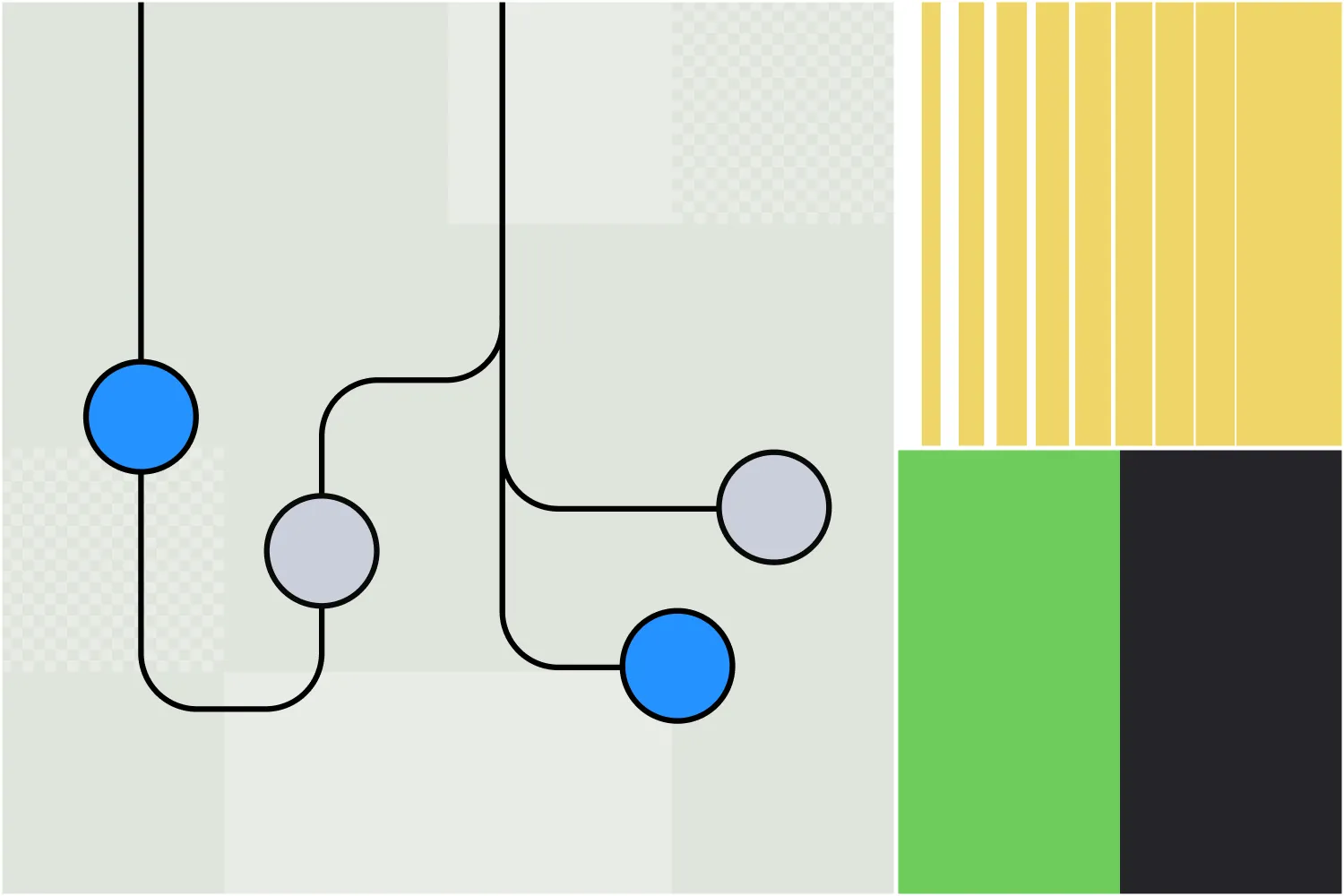

AI Agent na konektado sa Hubspot

Sa totoong aplikasyon, kunin natin ang isang AI agent na pinapagana ng LLM at isinama sa Hubspot. Ginagamit ito ng sales team para asikasuhin ang mga bagong lead na nakukuha mula sa iba’t ibang channel.

Senaryo

Isang salesperson ang nagpadala ng bagong lead sa AI agent at inutusan itong irehistro ito sa Hubspot at magpadala ng unang email, ngunit huwag itong gawin kung ang lead ay nagtatrabaho sa kumpanyang prospect na.

LLM na walang chain-of-thought reasoning

Ire-rehistro ng LLM-powered AI agent ang lead at magpapadala ng email nang hindi tinitingnan kung prospect na ang kumpanya, kaya hindi nasunod ang mahalagang kondisyon.

LLM na may chain-of-thought reasoning

Tinitingnan muna ng LLM-powered AI agent kung prospect na ang kumpanya bago kumilos. Kung prospect na, hindi na ito magre-rehistro at magpapadala ng email; kung hindi pa, ire-rehistro ang lead at magpapadala ng email, kaya tama ang pagsunod sa utos ng salesperson.

Kailan ko dapat gamitin ang chain-of-thought prompting?

Pinakamainam gamitin ang chain-of-thought prompting sa mga sitwasyong nangangailangan ng sunud-sunod na pag-iisip.

Ang mga pangunahing halimbawa ay mga gawain na may lohikal na pag-aanalisa, problema sa matematika, prosesong gawain, o anumang sitwasyon na nangangailangan ng sagot na may maraming hakbang.

Pero teka: maganda ang reasoning—bakit hindi ko na lang ito gamitin palagi?

Magandang tanong. Hindi lahat ng tanong ay nangangailangan ng pangangatwiran. Halimbawa:

- Mga simpleng factual na tanong, tulad ng ‘Ano ang kabisera ng Canada?’

- Mga problemang isang hakbang lang, gaya ng ‘Ano ang 145 + 37?’

- Mga gawain sa paggawa ng nilalaman, tulad ng ‘Gumawa ng magalang na 3-sentence na email na nagtatanong sa katrabaho ko kung tapos na sila sa kanilang proyekto.’

Prompt chaining vs chain-of-thought prompting

Bagaman magkahawig ang pangalan, magkaiba ang prompt chaining at chain-of-thought prompting bilang mga estratehiya sa pag-prompt para mapabuti ang output ng generative AI.

Chain-of-thought prompting

Sa chain-of-thought prompting, ginagabayan ng user ang AI na ipaliwanag ang proseso ng pag-iisip sa sagot nito sa isang tugon lang. Pinapadaan nito ang AI sa bawat hakbang ng paglutas ng problema, ngunit nagagawa ito sa isang prompt at sagot lang.

Halimbawa, maaaring magawa ang chain-of-thought prompt sa isang mensahe:

"Kailangang suriin ng HR team ang 5 performance evaluation ng empleyado. Bawat isa ay aabutin ng 30 minuto at kailangan ng 15 minutong paghahanda bago magsimula. Ang senior evals ay mangangailangan ng dagdag na 10 minuto bawat isa. Gaano katagal matatapos ang 5 senior at 25 junior evals? Ipaliwanag ang proseso ng pag-iisip mo, hakbang-hakbang."

Prompt chaining

Sa prompt chaining, hinahati ang gawain sa magkakahiwalay na hakbang gamit ang maraming prompt, na bawat isa ay nakabatay sa naunang resulta. Nakakatulong ito para maisaayos at magabayan ang AI sa masalimuot na gawain na nangangailangan ng reasoning.

Maaaring ganito ang unang prompt:

Prompt 1: Tukuyin ang mga pangunahing hamon na maaaring harapin ng isang kumpanya kapag lumilipat sa remote work.

Output:

- Mga puwang sa komunikasyon

- Pagpapanatili ng produktibidad

- Imprastraktura ng teknolohiya

- Pakikibahagi ng empleyado

Ang mga susunod na prompt ay maaaring sumuri pa sa mga konseptong ito. Halimbawa:

Prompt 2: Paano makakahanap ng solusyon ang isang kumpanya sa mga puwang sa komunikasyon kapag lumilipat sa remote work?

Pagkatapos ng susunod na output, maaaring ganito naman ang kasunod na bahagi ng chain:

Prompt 3: Ano ang mga karaniwang hamon na nararanasan ng mga kumpanya kapag ina-adopt nila ang mga solusyong ito?

Kaya bagama't magkahawig ang dalawa, magkaiba ang paraan nila ng pagkuha ng pinakamalalim at pinaka-angkop na nilalaman mula sa mga generative AI na kasangkapan.

Chain-of-thought prompting sa Botpress

Pamilyar na ang mga gumagamit ng Botpress sa isang tampok na gumagamit ng chain-of-thought na pag-iisip.

Ipinakilala ang Autonomous Node noong Hulyo 2024 sa Botpress, isang plataporma para sa paggawa ng AI agents. Ang Autonomous Node ay kayang mag-automate ng mga multi-step na workflow at magdesisyon nang mag-isa.

Maaaring gumawa ng Autonomous Node at bigyan ito ng prompt gamit ang isang simpleng linya ng teksto, tulad ng ‘Ang layunin mo ay makabuo ng mga kwalipikadong lead. Gumawa ng lead sa Salesforce kapag may nagpapakita ng intensyon na bumili ang isang user.’

Ang AI agent na gagawin mo gamit ang Autonomous Node na ito ay magsasagawa ng iba't ibang aksyon para maabot ang layunin nito, nang hindi umaasa sa mga workflow na dinisenyo ng tao. Maaari rin itong lumipat sa iba't ibang LLM kung kinakailangan, batay sa desisyong unahin ang bilis o lakas.

Gumawa ng sariling autonomous na agent

Ang Botpress lang ang AI agent platform na nagbibigay-daan sa iyo na gumawa ng tunay na autonomous na mga agent.

Ang bukas at nababagong Botpress Studio ay nagbibigay ng walang katapusang gamit sa iba't ibang industriya, mula HR hanggang lead generation. Sa aming handang gamiting integration library at malawak na mga tutorial, madaling makagawa ng AI agent mula sa simula ang mga user.

Simulan ang paggawa ngayon. Libre ito.

O makipag-ugnayan sa aming sales team.

FAQs

1. Ang chain-of-thought prompting ba ay kapaki-pakinabang lang para sa AI models, o sumasalamin din ito sa paraan ng paglutas ng tao ng problema?

Ang chain-of-thought prompting ay kapaki-pakinabang para sa parehong AI models at sumasalamin din sa paraan ng tao sa paglutas ng problema, dahil ginagaya nito kung paano natural na nilulutas ng mga tao ang komplikadong problema sa pamamagitan ng sunud-sunod na pag-iisip.

2. Paano naiiba ang chain-of-thought reasoning sa simpleng “pag-iisip nang sunud-sunod”?

Bagama't ang "pag-iisip nang sunud-sunod" ay pangkalahatang paraan, ang chain-of-thought reasoning ay mas organisado at sinasadya, hinihikayat ang AI model na malinaw na ipaliwanag ang mga hakbang ng pag-iisip sa halip na agad magbigay ng sagot.

3. Bakit may ilang LLM na hindi awtomatikong gumagamit ng chain-of-thought reasoning?

May ilang LLM, lalo na ang mga naunang bersyon o mas maliliit na modelo, na hindi awtomatikong gumagamit ng chain-of-thought reasoning dahil hindi sila na-fine-tune para gumawa ng multi-step na output at mas nakatuon sa paghula ng mga posibleng sagot batay sa pattern ng training data.

4. Ang chain-of-thought prompting ba ay isang uri ng “pagsasanay” sa modelo habang inference?

Hindi, ang chain-of-thought prompting ay hindi isang uri ng pagsasanay; hindi nito binabago ang weights o kaalaman ng modelo. Sa halip, ginagabayan nito ang kilos ng modelo habang inference sa pamamagitan ng pagbibigay ng istrukturadong prompt.

5. Palaging nagpapahusay ba ng accuracy ang chain-of-thought prompting?

Hindi palaging nagpapahusay ng katumpakan ang chain-of-thought prompting. Madalas itong nakakatulong sa mga gawain na nangangailangan ng sunud-sunod na pangangatwiran, ngunit sa mga simpleng gawain, maaari itong magdulot ng hindi kailangang komplikasyon at makabawas pa sa pagganap.

.webp)