- Halucynacja AI występuje, gdy modele z przekonaniem generują fałszywe lub zmyślone informacje, spowodowane niską jakością danych, przeuczeniem lub nieprecyzyjnymi zapytaniami.

- Halucynacje obejmują zarówno błędy merytoryczne, jak i wymyślone treści, co może prowadzić do utraty zaufania, kosztować firmy miliardy lub szerzyć szkodliwe dezinformacje.

- Kluczowe kroki zapobiegawcze to wybór zaufanych platform AI, wdrożenie generowania wspomaganego wyszukiwaniem (RAG), tworzenie precyzyjnych zapytań oraz zapewnienie nadzoru człowieka.

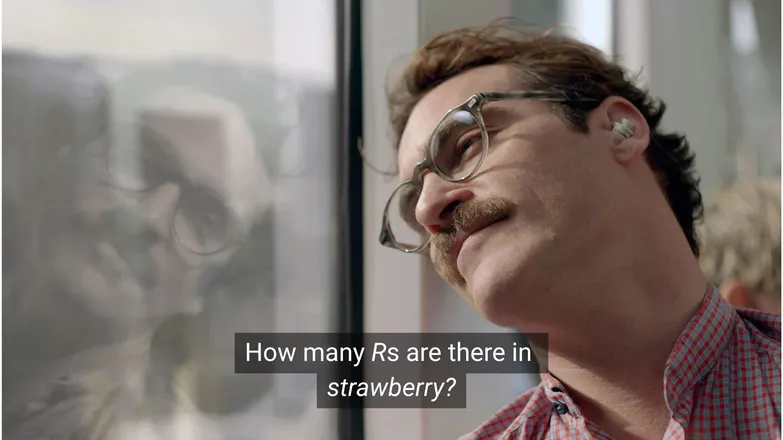

Myślisz, że Joaquin Phoenix zakochałby się w Scarlett Johansson, gdyby zapytał ją, ile R jest w słowie strawberry? Jeśli korzystasz z LinkedIn, znasz odpowiedź: 3. (Albo po prostu umiesz czytać.)

Ale dla czatbotów AI nie zawsze jest to takie proste.

Pewnie widziałeś, jak ludzie żartują z absurdalnych halucynacji AI. I trzeba przyznać, że model AI, który wydaje się mieć nieskończoną wiedzę, ludzkie rozumowanie i błyskawiczne tempo działania, a nie radzi sobie z zadaniem na poziomie przedszkola, to rzeczywiście dość absurdalne.

Jednak za tą zabawą kryje się poważniejsza – i potencjalnie groźna – rzeczywistość.

W tym artykule opowiem o halucynacjach AI – czym są, skąd się biorą, dlaczego są istotne i jak można im zapobiegać.

Czym jest halucynacja AI?

Halucynacja AI to sytuacja, gdy model AI przedstawia informacje nieprawdziwe, wprowadzające w błąd lub całkowicie zmyślone. Takie fałszywe dane mogą wydawać się wiarygodne i często pozostają niezauważone.

Ze względu na powszechność LLM-ów, o halucynacjach najczęściej mówi się w kontekście generatywnych modeli tekstowych. W rzeczywistości stanowią one ryzyko dla każdej aplikacji wykorzystującej Generative AI.

Co powoduje halucynacje w AI?

Halucynacje AI pojawiają się, gdy modele uczą się fałszywych wzorców.

Wzorce w kontekście AI to zdolność wykorzystywania pojedynczych przykładów treningowych do uogólniania na nowe, nieznane dane. Może to być ciąg słów tworzący kontynuację tekstu lub układ pikseli na obrazie odpowiadający psu.

W przypadku halucynacji LLM model uznaje pewien ciąg słów za najbardziej prawdopodobną odpowiedź na zapytanie użytkownika, mimo że jest ona nieprawdziwa.

Może to wynikać z jednej lub kilku z poniższych przyczyn:

Niska jakość danych treningowych

ChatGPT i podobne LLM-y są trenowane na ogromnych zbiorach danych. Te dane, choć liczne, są niedoskonałe z powodu:

- Braków w określonych tematach

- Odwzorowywania uprzedzeń obecnych w rzeczywistości

- Celowej dezinformacji lub nieoznaczonej satyry

- Stronniczości, czyli nierównomiernego rozkładu danych.

Wyobraź sobie sytuację, w której model był trenowany na informacjach o wszystkich greckich bogach oprócz jednego.

Jego zdolność do łączenia tematów związanych z mitologią grecką – miłość, etyka, zdrada – może sprawić, że „wymyśli” własną mitologię, która według modelu jest „prawdopodobna” statystycznie.

To widać także w generowaniu obrazów, gdzie większość zapytań dotyczących kobiecych postaci skutkuje przesadnie seksualizowanymi wizerunkami. Stronniczość w jednym kierunku warunkuje typ generowanych obrazów.

Pisownia strawberry prawdopodobnie pojawiała się w danych treningowych w kontekście rozmów o podwójnym R, co jest znanym problemem dla osób uczących się angielskiego. W tym przypadku liczba 2 lub słowo „double” zapewne pojawiały się w związku z pisownią tego słowa.

Z drugiej strony, mało prawdopodobne, by dane wspominały o trzech R w tym słowie.

Odpowiedź jest absurdalna, bo zapytanie brzmi: w jakiej sytuacji ktoś napisałby słowo, a potem pytał o jego pisownię?

Architektura modelu i metoda generowania

Modele te opierają się na niezwykle złożonych architekturach sieci neuronowych. Nawet drobne różnice wpływają na to, jak modele współpracują z danymi treningowymi i wejściowymi promptami. Zdolność modelu do ograniczania halucynacji jest stopniowo ulepszana dzięki intensywnym badaniom i testom.

Dodatkowo istotny jest sposób generowania. Modele przewidują najbardziej prawdopodobne kolejne słowo (a właściwie fragment słowa). Na przykład:

„The quick brown fox jumps over the lazy ___.”

Model uzna, że najbardziej prawdopodobnym słowem jest „dog”. Ale możliwe są też inne odpowiedzi. Generowanie wyłącznie na podstawie najbardziej prawdopodobnego słowa prowadzi jednak do nudnych, przewidywalnych rezultatów.

Dlatego stosuje się kreatywne metody próbkowania, by odpowiedzi były ciekawe, ale spójne. W efekcie czasem dokładność faktów schodzi na dalszy plan.

Przeuczenie (overfitting)

Przeuczenie to sytuacja, gdy model tak bardzo dopasowuje się do danych treningowych, że nie potrafi uogólniać na nowe przypadki.

Gdybym był modelem (jak mówi moja mama, że powinienem), byłbym dobrze wytrenowany, jeśli rozpoznawałbym psy jako:

Futrzaste, z oklapniętymi uszami, wesołe i z małym brązowym noskiem.

Ale byłbym przeuczony, gdybym rozpoznawał je tylko jako:

Z brązową plamką pod brodą, reagujące na imię „Frank” i całkowicie pogryzły moje dobre buty Nike.

W przypadku LLM przeuczenie zwykle objawia się powtarzaniem informacji z danych treningowych zamiast przyznania, że nie zna odpowiedzi.

Jeśli zapytasz czatbota o politykę zwrotów firmy, a on nie zna odpowiedzi, powinien to powiedzieć. Jeśli jest przeuczony, może podać politykę zwrotów innej, podobnej firmy.

Nieprecyzyjne zapytania

Firmy wydają certyfikaty z inżynierii promptów, wiedząc, że AI jest tak dobra, jak jej dane wejściowe.

Dobrze sformułowany prompt jest precyzyjny, unika specjalistycznego żargonu i zawiera cały potrzebny kontekst.

Dzieje się tak, ponieważ halucynacje pojawiają się na granicy wielu niskoprawdopodobnych odpowiedzi.

Załóżmy, że pytasz „jaka jest fabuła shark girl?”. Człowiek pomyśli „hmm, shark girl.” W świecie statystyki możliwości są takie:

- The Adventures of Sharkboy and Lavagirl – dość popularny film dla dzieci z 2005 roku o podobnej nazwie.

- Horror/thriller z 2024 roku pt. Shark Girl – mniej znany, ale nowszy i bardziej zgodny z pytaniem.

- Książka dla dzieci o tym samym tytule wydana na początku tego roku – model mógł ją zindeksować, ale nie musi.

Żadna z tych opcji nie jest oczywista, co prowadzi do „spłaszczonego” rozkładu prawdopodobieństwa i braku zdecydowania co do tematu. Skuteczniejszy prompt zawierałby kontekst, czyli doprecyzowanie, o który przykład chodzi użytkownikowi.

Ta mieszanka niejasności i luźnych powiązań może skutkować odpowiedzią będącą po prostu wymyśloną, ogólną fabułą historii o rekinach.

Zmniejszenie ryzyka halucynacji polega na ograniczeniu niepewności.

Rodzaje halucynacji AI

Dotychczas omawiałem halucynacje ogólnie. W rzeczywistości dotyczą one niemal wszystkich aspektów AI. Dla jasności warto jednak wyróżnić różne kategorie.

Błędy faktograficzne

To tutaj pasuje przykład z truskawką. Chodzi o błędy w szczegółach w zasadniczo poprawnych odpowiedziach. Mogą to być np. rok wydarzenia, stolica kraju czy liczby statystyczne.

Drobne szczegóły w dobrej odpowiedzi mogą być szczególnie podstępne, zwłaszcza jeśli dotyczą faktów, których ludzie zwykle nie pamiętają, np. dokładnych liczb.

Zmyślone treści

W 2023 roku Bard od Google błędnie stwierdził, że teleskop Jamesa Webba został użyty do wykonania pierwszych zdjęć egzoplanet. To nie była kwestia technicznych nieścisłości – to było po prostu nieprawdziwe.

Takie przypadki mogą być śmiałymi twierdzeniami, jak powyżej, ale częściej pojawiają się jako nieistniejące adresy URL lub wymyślone biblioteki i funkcje programistyczne.

Warto zauważyć, że granica między błędami merytorycznymi a zmyślonymi treściami nie zawsze jest wyraźna.

Załóżmy, że rozmawiamy o naukowcu. Jeśli podamy tytuł jego publikacji, ale pomylimy rok – to błąd merytoryczny. A jeśli pomylimy nazwisko? A co, jeśli pomylimy zarówno nazwisko, jak i rok?

Dezinformacja

Może to podpadać pod jedną z dwóch poprzednich kategorii, ale odnosi się do fałszywych informacji, gdzie źródło jest bardziej przejrzyste.

Słynny przypadek, gdy Google AI polecał pizzę z klejem i jedzenie kamieni, jest świetnym przykładem; źródło tych treści było oczywiście satyryczne i generalnie nieszkodliwe – komentarze z Reddita napisane przez The Onion, ale model nie był na to przygotowany.

Ryzyka związane z halucynacjami AI

1. Utrata zaufania

Doceniamy wygodę powierzania zadań AI, ale nie kosztem naszego zaufania.

Niedawna wpadka Cursor AI – bot obsługi klienta wymyślił restrykcyjną politykę – sprawiła, że wielu użytkowników zrezygnowało z subskrypcji, kwestionując jego wiarygodność.

2. Koszty

AI odgrywa kluczową rolę w wielu firmach i choć to pozytywne, pomyłka może być kosztowna.

Halucynacja Google dotycząca teleskopu Jamesa Webba spowodowała spadek wartości akcji Alphabet o 100 miliardów dolarów w ciągu kilku godzin. I to jeszcze przed kosztami ponownego trenowania modeli.

3. Szkodliwa dezinformacja

Śmiejemy się z absurdu pizzy z klejem, ale co z fałszywymi dawkami leków?

Sam chętnie zamienię czytanie ostrzeżeń drobnym drukiem na szybką odpowiedź od AI. Ale co, jeśli będzie błędna? AI niemal na pewno nie uwzględni wszystkich możliwych schorzeń.

3. Bezpieczeństwo i złośliwe oprogramowanie

Jak wspomniano, AI często wymyśla nazwy bibliotek i funkcji programistycznych. Jeśli spróbujesz zainstalować nieistniejącą bibliotekę, nic się nie stanie.

Wyobraź sobie jednak, że haker umieszcza złośliwe oprogramowanie w kodzie i publikuje je pod nazwą często „halucynowanej” biblioteki. Instalujesz ją i 💨puf💨: zostałeś zhakowany.

To zjawisko istnieje i nazywa się slopsquatting.

Pomijając nieprzyjemną nazwę, zawsze warto krytycznie podchodzić do tego, co instalujesz, i podwójnie sprawdzać egzotycznie brzmiące biblioteki.

Jak zapobiegać halucynacjom AI

Jeśli nie trenujesz modeli samodzielnie, masz ograniczony wpływ na dane i architekturę.

Dobra wiadomość jest taka, że nadal możesz podjąć środki ostrożności, które mogą całkowicie zmienić sytuację i umożliwić wdrożenie AI wolnej od halucynacji.

Wybierz model i platformę, którym możesz zaufać

Nie jesteś zdany tylko na siebie. Firmom AI zależy na utrzymaniu zaufania, a to oznacza brak halucynacji.

W zależności od zastosowania AI, zazwyczaj masz kilka opcji, a dobra platforma AI to ułatwia. Takie platformy powinny jasno informować jak ograniczają halucynacje.

Stosuj RAG (Retrieval-Augmented Generation)

Nie polegaj wyłącznie na wiedzy modelu. Wyposażenie go w RAG zapewnia dostęp do aktualnych informacji i wskazuje, gdzie je znaleźć.

Najlepiej korzystać z AI na platformie, która jasno tłumaczy jak skutecznie wdrożyć RAG.

Dodaj szczegółowe instrukcje

To truizm, ale prawdziwy: śmieci na wejściu, śmieci na wyjściu.

„Odpowiedz na pytanie użytkownika” nie gwarantuje sukcesu. Jednak coś w stylu:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.pozwoli utrzymać agenta w ryzach. Jasne instrukcje i wyraźne ograniczenia to najlepsza ochrona przed nieprzewidywalnym agentem.

Weryfikacja przez człowieka

W kwestii eskalacji warto mieć osobę gotową do sprawdzenia, oceny i wyeliminowania niedociągnięć AI.

Możliwość eskalacji lub weryfikacji rozmów pozwala ustalić, co działa, a co grozi halucynacją. Human-in-the-loop – nadzór człowieka nad procesami AI – to tutaj konieczność.

Korzystaj z AI wolnej od halucynacji już dziś

Niepewność co do niezawodności AI może powstrzymywać firmy przed cyfrową transformacją.

Funkcje RAG w Botpress, integracja human-in-the-loop i zaawansowane systemy bezpieczeństwa sprawiają, że AI jest bezpieczna i godna zaufania. Twój agent pracuje dla ciebie, a nie odwrotnie.

Zacznij budować już dziś. To nic nie kosztuje.

Najczęstsze pytania

1. Jak rozpoznać, czy odpowiedź AI to halucynacja, nie mając wiedzy o danym temacie?

Aby rozpoznać halucynację AI bez wcześniejszej wiedzy, zwróć uwagę na bardzo szczegółowe twierdzenia, przesadnie pewny ton lub nazwy, statystyki czy cytaty, których nie da się samodzielnie zweryfikować. W razie wątpliwości poproś AI o podanie źródeł lub sprawdź informacje w wiarygodnych zewnętrznych źródłach.

2. Jak często występują halucynacje AI w dużych modelach językowych (LLM)?

Halucynacje AI są częste w dużych modelach językowych, ponieważ generują tekst na podstawie prawdopodobieństw, a nie weryfikacji faktów. Nawet zaawansowane modele, takie jak GPT-4o czy Claude 3.5, mogą podawać nieprawdziwe informacje, zwłaszcza przy pytaniach o niszowe tematy lub w sytuacjach z małą ilością kontekstu.

3. Czy halucynacje zdarzają się także w modelach AI generujących obrazy?

Tak, halucynacje występują również w modelach generujących obrazy – objawiają się np. nienaturalnymi lub bezsensownymi elementami, jak dodatkowe kończyny czy błędne przedstawienia kulturowe, wynikające z uprzedzeń lub braków w danych treningowych.

4. Czy halucynacje są częstsze w niektórych językach lub kulturach z powodu uprzedzeń w danych treningowych?

Halucynacje są częstsze w językach mniej reprezentowanych lub w kontekstach poza kulturą zachodnią, ponieważ większość LLM jest trenowana głównie na danych anglojęzycznych i zachodnich, co prowadzi do mniej trafnych odpowiedzi kulturowych.

5. Które branże są najbardziej narażone na skutki halucynacji AI?

Branże takie jak opieka zdrowotna, finanse, prawo i obsługa klienta są najbardziej narażone na skutki halucynacji AI, ponieważ błędne odpowiedzi w tych dziedzinach mogą prowadzić do naruszeń przepisów, strat finansowych, problemów prawnych lub utraty zaufania użytkowników i reputacji marki.

.webp)