- Halusinasi AI terjadi ketika model dengan yakin menghasilkan informasi yang salah atau dibuat-buat, biasanya disebabkan oleh kualitas data yang buruk, overfitting, atau perintah yang ambigu.

- Halusinasi dapat berupa kesalahan fakta hingga konten yang sepenuhnya dibuat-buat dan dapat merusak kepercayaan, menyebabkan kerugian miliaran dolar bagi bisnis, atau menyebarkan misinformasi berbahaya.

- Langkah utama pencegahan meliputi memilih platform AI yang tepercaya, menambahkan retrieval-augmented generation (RAG), membuat prompt yang jelas, dan melibatkan pengawasan manusia.

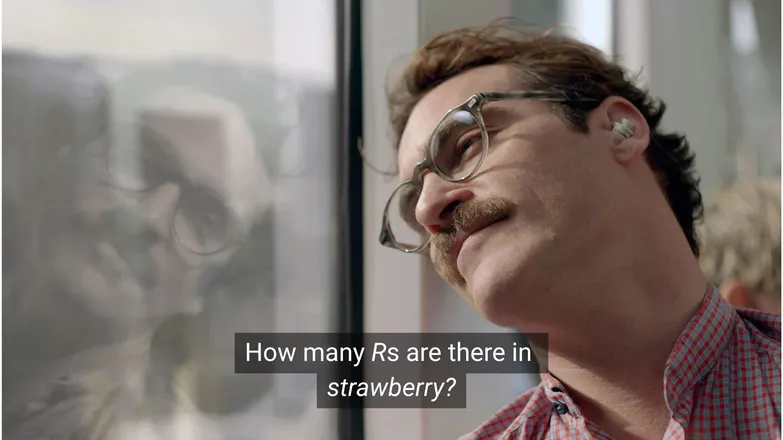

Menurutmu, apakah Joaquin Phoenix akan jatuh cinta pada Scarlett Johansson jika ia bertanya berapa banyak huruf R dalam strawberry? Kalau kamu sering di LinkedIn, pasti tahu jawabannya adalah 3. (Atau, ya, kalau kamu bisa membaca.)

Namun bagi chatbot AI, hal ini tidak selalu sesederhana itu.

Kamu mungkin pernah melihat orang-orang menertawakan absurditas halusinasi AI. Dan memang, model AI dengan pengetahuan tampak tak terbatas, kemampuan bernalar seperti manusia, dan kecepatan eksekusi yang luar biasa, gagal dalam soal matematika tingkat TK memang cukup absurd.

Namun di balik candaan itu, ada kenyataan yang lebih serius — dan berpotensi berbahaya.

Di artikel ini, saya akan membahas tentang halusinasi AI—apa itu, penyebabnya, mengapa penting, dan langkah-langkah yang bisa kamu lakukan untuk mencegahnya.

Apa itu halusinasi AI?

Halusinasi AI adalah ketika model AI menyajikan informasi yang tidak akurat, menyesatkan, atau sepenuhnya dibuat-buat. Informasi palsu ini bisa tampak meyakinkan, dan sering kali tidak terdeteksi.

Karena penggunaan LLM yang luas, istilah halusinasi biasanya merujuk pada model teks generatif. Namun kenyataannya, hal ini bisa terjadi pada aplikasi Generative AI apa pun.

Apa penyebab halusinasi pada AI?

Halusinasi AI terjadi ketika model mempelajari pola yang salah.

Pola dalam konteks AI mengacu pada kemampuannya menggunakan contoh pelatihan untuk menggeneralisasi ke data yang belum pernah dilihat. Ini bisa berupa rangkaian kata untuk melanjutkan sebuah teks, atau distribusi piksel gambar yang menggambarkan seekor anjing.

Pada kasus halusinasi LLM, model menganggap rangkaian kata tertentu sebagai kelanjutan paling mungkin dari permintaan pengguna, meskipun sebenarnya salah.

Hal ini bisa terjadi karena satu atau beberapa alasan berikut:

Data Pelatihan Berkualitas Rendah

ChatGPT dan LLM serupa dilatih dengan data dalam jumlah besar. Namun, data ini tetap tidak sempurna karena:

- Kekurangan pada topik tertentu

- Mencerminkan prasangka dunia nyata

- Misinformasi sengaja atau satire yang tidak ditandai

- Bias, seperti data yang tidak seimbang atau “berat sebelah”.

Bayangkan skenario di mana model dilatih dengan informasi tentang semua dewa Yunani kecuali satu.

Kemampuannya menghubungkan topik-topik mitologi Yunani—cinta, etika, pengkhianatan—bisa membuatnya merangkai mitos buatan yang dianggapnya “mungkin”, berdasarkan model statistiknya.

Hal ini juga terlihat pada pembuatan gambar, di mana sebagian besar permintaan untuk subjek perempuan menghasilkan gambar yang sangat seksual. Bias terhadap satu jenis penggambaran mempengaruhi jenis gambar yang dihasilkan.

Ejaan strawberry kemungkinan sering muncul dalam data pelatihan dalam konteks diskusi tentang R ganda, yang sering menyulitkan penutur non-Inggris. Dalam kasus ini, angka 2 atau kata “double” kemungkinan besar muncul terkait ejaan kata tersebut.

Sebaliknya, kecil kemungkinan data menyebutkan bahwa kata itu memiliki 3 R.

Hasilnya jadi aneh karena prompt-nya: dalam situasi apa seseorang menulis sebuah kata lalu bertanya bagaimana ejaannya?

Arsitektur Model dan Metode Generasi

Model dibangun dari arsitektur neural network yang sangat kompleks. Sedikit variasi dapat memengaruhi cara model berinteraksi dengan data pelatihan dan prompt yang diberikan. Kemampuan model untuk mengurangi halusinasi dapat ditingkatkan secara bertahap melalui penelitian dan pengujian yang ketat.

Selain itu, cara generasi dilakukan juga berpengaruh. Kata demi kata (sebenarnya word-piece), model memprediksi kata berikutnya yang paling mungkin. Jadi:

“The quick brown fox jumps over the lazy ___.”

Model akan menentukan kata berikutnya yang paling mungkin adalah “dog”. Tapi kata lain juga mungkin muncul. Dan jika hanya mengandalkan kata berikutnya yang paling mungkin, hasilnya jadi membosankan dan mudah ditebak.

Artinya, metode sampling kreatif perlu digunakan agar respons tetap menarik dan koheren. Namun, dalam proses ini, kadang-kadang fakta jadi terabaikan.

Overfitting

Overfitting terjadi ketika model dilatih terlalu menyesuaikan data sehingga gagal menggeneralisasi pada input baru.

Jadi, jika saya adalah model (kata ibu saya saya seharusnya begitu), saya akan terlatih dengan baik jika saya mengenali anjing sebagai:

Berbulu, bertelinga turun, suka bermain, dan hidung kecil berwarna cokelat.

Tapi saya akan overfit jika hanya mengenali anjing sebagai:

Ada titik cokelat di bawah dagunya, namanya “Frank”, dan sudah mengunyah habis sepatu Nike kesayangan saya.

Dalam konteks LLM, biasanya ini terlihat dari model yang hanya mengulang informasi dari data pelatihan, bukannya mengakui jika tidak tahu jawabannya.

Misal kamu bertanya ke chatbot tentang kebijakan pengembalian barang sebuah perusahaan. Jika tidak tahu, seharusnya chatbot memberi tahu. Tapi jika overfit, ia mungkin malah memberikan kebijakan perusahaan lain yang mirip.

Prompt yang Buruk

Banyak perusahaan kini mengeluarkan sertifikat prompt engineering karena AI hanya sebaik input yang diberikan.

Prompt yang baik dirumuskan dengan jelas, menghindari istilah khusus, dan memberikan semua konteks yang diperlukan.

Ini karena halusinasi sering terjadi pada area dengan kemungkinan keluaran rendah.

Misal kamu bertanya “apa plot dari shark girl?” Manusia akan berpikir “hmm, shark girl.” Dalam dunia statistik, kemungkinannya adalah:

- The Adventures of Sharkboy and Lavagirl – film anak-anak yang cukup populer dari 2005 dengan nama mirip.

- Film horor/thriller tahun 2024 berjudul Shark Girl – kurang populer tapi lebih baru dan sesuai.

- Buku anak-anak dengan judul sama dari awal tahun ini – yang mungkin sudah atau belum diindeks oleh model.

Tidak ada yang benar-benar jelas, sehingga distribusi probabilitasnya jadi “datar” dan model tidak yakin pada satu topik atau narasi. Prompt yang lebih efektif akan memberikan konteks, misalnya menyebutkan contoh mana yang dimaksud pengguna.

Campuran ambiguitas dan relevansi yang samar ini bisa menghasilkan jawaban yang juga demikian: plot generik buatan tentang cerita bertema hiu.

Mengurangi kemungkinan halusinasi berarti mengurangi ketidakpastian.

Jenis-jenis Halusinasi AI

Sejauh ini saya membahas halusinasi secara umum. Kenyataannya, hal ini menyentuh hampir semua aspek AI. Namun demi kejelasan, sebaiknya kita lihat kategori-kategorinya.

Kesalahan Fakta

Contoh strawberry masuk di sini. Ada kesalahan detail pada pernyataan yang sebetulnya benar. Ini bisa berupa tahun suatu peristiwa, ibu kota negara, atau angka statistik.

Detail kecil dalam jawaban yang sebetulnya baik bisa sangat berbahaya, terutama untuk hal-hal yang jarang diingat manusia, seperti angka pasti.

Konten yang Direkayasa

Pada tahun 2023, Bard milik Google secara keliru mengklaim bahwa teleskop James Webb digunakan untuk mengambil foto pertama exoplanet. Ini bukan soal ketidakakuratan teknis—ini benar-benar salah.

Klaim seperti ini bisa saja terdengar bombastis seperti di atas, namun lebih sering muncul dalam bentuk URL yang tidak mengarah ke mana-mana, atau pustaka kode dan fungsi yang dibuat-buat.

Perlu dicatat bahwa batas antara kesalahan fakta dan konten yang direkayasa tidak selalu jelas.

Misalnya kita membahas seorang peneliti. Jika kita mengutip makalahnya tapi salah tahun, itu adalah kesalahan fakta. Tapi jika kita salah nama, bagaimana? Bagaimana jika salah nama dan tahun?

Misinformasi

Ini bisa termasuk dalam dua kategori sebelumnya, namun merujuk pada informasi salah di mana sumbernya lebih transparan.

AI Google pernah menyarankan pizza dengan lem dan makan batu—contoh yang bagus; sumber aslinya jelas bersifat satir dan umumnya tidak berbahaya—komentar Reddit yang ditulis oleh The Onion, namun pelatihan modelnya tidak memperhitungkan hal itu.

Risiko Halusinasi AI

1. Hilangnya Kepercayaan

Kita senang bisa menyerahkan tugas pada AI, tapi tidak jika harus mengorbankan kepercayaan.

Insiden terbaru pada Cursor AI—bot layanan pelanggan yang menciptakan kebijakan pembatasan—membuat banyak pengguna membatalkan langganan dan meragukan keandalannya.

2. Biaya

AI kini menjadi andalan di banyak bisnis, dan meski itu hal baik, satu kesalahan bisa sangat mahal.

Halusinasi James Webb oleh Google menyebabkan penurunan nilai saham Alphabet sebesar $100 miliar hanya dalam beberapa jam. Itu bahkan belum termasuk biaya pelatihan ulang model.

3. Misinformasi yang Berbahaya

Kita mungkin menertawakan pizza dengan lem, tapi bagaimana dengan dosis medis yang menyesatkan?

Saya sendiri lebih suka jawaban cepat dari AI daripada membaca peringatan panjang. Tapi bagaimana jika jawabannya salah? Hampir pasti AI tidak mempertimbangkan semua kondisi medis yang mungkin.

3. Keamanan dan Malware

Seperti disebutkan, AI sering membuat nama pustaka kode yang tidak ada. Jika Anda mencoba menginstal pustaka yang tidak ada, tidak akan terjadi apa-apa.

Sekarang bayangkan seorang peretas menyisipkan malware ke dalam kode dan mengunggahnya dengan nama pustaka yang sering dihalusinasikan. Anda menginstal pustaka itu, dan 💨poof💨: Anda kena hack.

Hal ini benar-benar ada, dan disebut slopsquatting.

Terlepas dari namanya yang aneh, selalu baik untuk kritis terhadap apa yang Anda instal, dan periksa ulang nama pustaka yang terdengar asing.

Langkah-langkah Mencegah Halusinasi AI

Jika Anda tidak melatih modelnya sendiri, tidak banyak yang bisa dilakukan dari sisi data dan arsitektur.

Kabar baiknya, masih ada langkah pencegahan yang bisa Anda ambil, dan ini bisa sangat menentukan dalam menghadirkan AI tanpa halusinasi.

Pilih Model dan Platform yang Terpercaya

Anda tidak sendirian. Perusahaan AI sangat berkepentingan menjaga kepercayaan, artinya tidak boleh ada halusinasi.

Tergantung pada penggunaan AI Anda, biasanya ada beberapa pilihan, dan platform AI yang baik membuatnya mudah diakses. Platform ini harus transparan tentang cara mereka mengurangi halusinasi.

Gunakan RAG (Retrieval-Augmented Generation)

Jangan biarkan model hanya mengandalkan pengetahuannya sendiri. Dengan RAG, informasi yang tersedia dan sumbernya menjadi jelas.

Sebaiknya gunakan AI di platform yang menyediakan petunjuk sederhana tentang cara menerapkan RAG yang efektif.

Tambahkan Instruksi yang Jelas

Anda pasti sering mendengar: sampah masuk, sampah keluar.

“Jawab pertanyaan pengguna” tidak menjamin hasil yang baik. Namun, instruksi seperti:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.akan menjaga agen Anda tetap terkendali. Prompt yang jelas dengan batasan tegas adalah pertahanan terbaik terhadap agen yang menyimpang.

Verifikasi oleh Manusia

Terkait eskalasi, penting untuk memiliki seseorang yang siap memeriksa, mengevaluasi, dan mengatasi kekurangan AI.

Kemampuan untuk mengeskalasi atau memverifikasi percakapan secara retroaktif memungkinkan Anda mengetahui apa yang efektif dan apa yang berisiko halusinasi. Human-in-the-loop—pengawasan manusia pada alur kerja berbasis AI—adalah wajib di sini.

Gunakan AI Bebas Halusinasi Sekarang

Keraguan terhadap keandalan AI mungkin membuat bisnis ragu melakukan transformasi digital.

Kemampuan RAG Botpress, integrasi human-in-the-loop, dan sistem keamanan yang menyeluruh membuat AI menjadi aman dan andal. Agen Anda bekerja untuk Anda, bukan sebaliknya.

Mulai bangun hari ini. Gratis.

FAQ

1. Bagaimana saya bisa tahu apakah respons AI adalah halusinasi tanpa pengetahuan sebelumnya tentang topiknya?

Untuk mengetahui apakah respons AI adalah halusinasi tanpa pengetahuan sebelumnya, perhatikan tanda-tanda seperti klaim yang sangat spesifik, bahasa yang terlalu percaya diri, atau nama, statistik, atau kutipan yang tidak bisa diverifikasi secara independen. Jika ragu, minta AI mencantumkan sumbernya atau periksa silang dengan referensi eksternal yang tepercaya.

2. Seberapa sering halusinasi AI terjadi pada model bahasa besar (LLM)?

Halusinasi AI umum terjadi pada model bahasa besar karena mereka menghasilkan teks berdasarkan probabilitas, bukan verifikasi fakta. Bahkan model canggih seperti GPT-4o dan Claude 3.5 bisa menghasilkan keluaran yang tidak akurat, terutama untuk topik khusus atau dalam situasi dengan konteks minim.

3. Apakah halusinasi juga bisa terjadi pada model AI non-teks seperti pembuat gambar?

Ya, halusinasi juga terjadi pada model pembuat gambar, biasanya berupa elemen yang tidak realistis atau tidak masuk akal dalam hasilnya—seperti anggota tubuh berlebih atau representasi budaya yang salah—akibat bias atau kekurangan data pelatihan.

4. Apakah halusinasi lebih sering terjadi pada bahasa atau budaya tertentu karena bias data pelatihan?

Halusinasi lebih sering terjadi pada bahasa yang kurang terwakili atau konteks budaya non-Barat karena sebagian besar LLM dilatih terutama dengan data berbahasa Inggris dan berfokus pada Barat, sehingga responsnya kurang bernuansa budaya.

5. Industri apa saja yang paling berisiko akibat halusinasi AI?

Industri seperti kesehatan, keuangan, hukum, dan layanan pelanggan paling berisiko terhadap halusinasi AI, karena keluaran yang tidak akurat di bidang ini dapat menyebabkan pelanggaran kepatuhan, kerugian finansial, kesalahan hukum, atau merusak kepercayaan pengguna dan reputasi merek.

.webp)