- Botpress propose une tarification transparente, sans frais cachés liés à l’IA. Vos coûts d’IA reflètent uniquement votre utilisation réelle.

- Mettre en cache les réponses de l’IA peut réduire les coûts de requêtes d’environ 30 % sans nuire à l’expérience utilisateur.

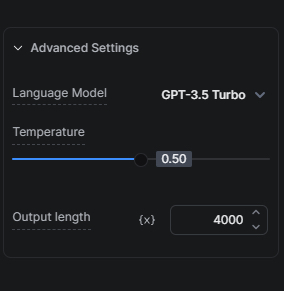

- Choisir le bon modèle d’IA, comme commencer avec GPT-3.5 Turbo plutôt que GPT-4, est essentiel pour équilibrer coût et qualité.

De nombreuses entreprises cherchent à exploiter le potentiel de l’IA sans dépasser leur budget. Nous comprenons l’importance de cet équilibre et nous nous engageons à proposer des solutions permettant à nos utilisateurs de profiter de l’IA de façon rentable.

Notre approche du coût de l’IA

Pour commencer, il est important de comprendre deux éléments clés de notre démarche pour réduire les coûts liés à l’IA tout en offrant ses avantages.

Tarification transparente : aucun frais caché

Nous n’ajoutons aucune marge sur les tâches liées à l’IA. Ainsi, vos dépenses en IA sont directement liées à votre utilisation réelle, sans frais supplémentaires de notre part.

Mise en cache des réponses de l’IA

La mise en cache des réponses de l’IA est l’une de nos stratégies les plus efficaces pour réduire les coûts de vos bots. En stockant les réponses, nous diminuons le nombre de requêtes envoyées au fournisseur LLM, ce qui peut réduire les coûts d’environ 30 % sans compromettre la qualité des échanges entre le bot et vos utilisateurs.

Conseils pour optimiser les coûts liés à l’IA

Après avoir vu deux de nos approches pour réduire les dépenses en IA, voici des conseils à appliquer lors de la création de votre bot pour diminuer encore davantage ces coûts.

Optimisez vos bases de connaissances

L’optimisation de vos bases de connaissances (KB) a un impact important sur vos dépenses en IA, car elles représentent souvent la principale source de coût dans un projet Botpress.

Conseil 1 : Choisissez le bon modèle d’IA

Le choix du modèle d’IA a un impact direct sur le coût. GPT-3.5 Turbo est plus rapide et moins cher que GPT-4 Turbo : nous recommandons donc de tester votre configuration avec GPT-3.5 Turbo avant d’envisager une version plus avancée.

Le mode hybride de notre agent KB offre un bon compromis : nous utilisons d’abord GPT-3.5 Turbo pour répondre à une requête, puis nous passons à GPT-4 Turbo uniquement si nécessaire.

Conseil 2 : Protégez votre base de connaissances

Vous pouvez réduire vos dépenses en IA en protégeant votre KB des FAQ classiques qui ne nécessitent pas d’IA ou de réponse intelligente, grâce à la carte Find Records. Par exemple : si vous savez que les utilisateurs posent souvent une question parmi 50 questions connues avec leurs réponses, ajoutez-les dans un tableau et interrogez ce tableau via une carte Find Records. Si aucune réponse n’est trouvée, alors seulement la KB est consultée.

Conseil 3 : Définissez bien le périmètre de vos bases de connaissances

Selon le type et la quantité d’informations à ajouter dans une KB, il est conseillé de faire deux choses en parallèle pour réduire les coûts : d’abord, organisez vos informations dans plusieurs petites KB, chacune dédiée à un produit, une fonctionnalité ou un sujet précis. Ensuite, guidez l’utilisateur via un parcours avec plusieurs questions pour cibler la recherche sur une KB spécifique ; cela réduit les coûts et améliore la pertinence des résultats.

Conseil 4 : Source de données KB site web vs Recherche sur le web

Si vous utilisez un site web comme source de données KB mais que vous ne modifiez pas fréquemment ce site, une alternative économique consiste à utiliser la recherche sur le web comme source de données KB au lieu du site web. Avant de faire ce changement, vérifiez que les performances sur les questions attendues ne sont pas dégradées.

Conseil 5 : Interrogez les tableaux avec Find Records ou la carte Exécuter du code

Si vous disposez d’un tableau à interroger, privilégiez la carte Find Records plutôt que d’utiliser le tableau dans une KB. Pour les utilisateurs techniques, exécuter du code peut être encore plus économique : interrogez directement le tableau depuis la carte Exécuter du code et stockez le résultat dans une variable de workflow à réutiliser ensuite.

Conseil 6 : Contrôlez les segments

Par « segments », j’entends le nombre de parties extraites de la base de connaissances pour générer une réponse. Plus il y a de segments, plus la réponse est précise, mais cela prend plus de temps et coûte plus de jetons IA. Faites des essais pour trouver le nombre minimal de segments permettant d’obtenir des réponses fiables.

Utilisez la carte Exécuter du code pour réduire les coûts liés à l’IA

La carte Exécuter du code peut remplacer avantageusement certaines cartes IA. Voici quelques cas où vous pouvez l’utiliser :

Alternatives intelligentes pour les messages

Si vous souhaitez que votre bot envoie une réponse IA différente à chaque fois pour une même question, il faut désactiver la mise en cache (voir l’annexe pour savoir comment faire). Dans certains cas, l’augmentation des coûts peut se justifier par une meilleure expérience utilisateur. Mais ce n’est pas toujours pertinent.

Prenons l’exemple d’un simple message de bienvenue généré par un LLM. À chaque salutation, vous payez un coût supplémentaire. Est-ce utile ? Probablement pas. Heureusement, il existe une solution économique : utilisez un tableau de réponses et une fonction simple pour en choisir une au hasard.

Selon le volume de conversations, les économies réalisées grâce à cette méthode peuvent être significatives.

Vous trouverez plus de détails sur comment mettre en place des messages alternatifs ici.

Exécution de code pour des tâches simples

Pour des tâches simples, comme reformater des données ou extraire des informations structurées, la carte Exécuter du code est souvent plus efficace, moins coûteuse et plus rapide qu’un LLM.

Alternatives à l’agent de résumé

Vous pouvez utiliser les cartes Exécuter du code pour créer votre propre historique de conversation. Placez une carte Exécuter du code à chaque endroit où vous souhaitez enregistrer les messages utilisateur et bot dans un tableau. Vous pourrez ensuite utiliser ce tableau comme contexte pour votre KB.

Simplifiez dès que possible

Privilégiez la méthode d’interaction la plus simple qui atteint le même objectif sans dégrader l’expérience utilisateur. Par exemple, pour recueillir un avis, un système de notation par étoiles avec commentaire sera plus économique que de passer par l’IA.

Conseils pour les tâches IA, la génération de texte IA et les traductions

Choisissez le bon modèle d’IA

Oui, le choix du modèle d’IA est si important qu’il mérite d’être rappelé. Comme pour les KB, ce choix a un impact direct sur le coût des tâches IA. Privilégiez GPT-3.5 Turbo pour les instructions simples. Avant d’envisager une version plus avancée, testez bien votre configuration avec ce modèle. Rappelez-vous : GPT-4 Turbo coûte 20 fois plus que GPT-3.5 Turbo. Sauf si les résultats sont nettement meilleurs, préférez GPT-3.5 Turbo.

En plus de cela, vous pouvez aussi réduire vos dépenses en limitant le nombre de jetons utilisés à chaque exécution de tâche IA.

Je recommande de bien réfléchir avant de diminuer ce nombre, car tout jeton supplémentaire sera tronqué. Par exemple, si vous limitez à 2 000 jetons et que votre prompt plus la sortie dépassent ce seuil, votre entrée sera coupée en conséquence.

Tâche IA vs Génération de texte IA

Pour des sorties textuelles simples, la carte Générer du texte IA consomme moins de jetons et est plus facile à configurer que la carte Tâche IA. Pour des tâches d’analyse ou d’extraction d’informations, la carte Tâche IA est plus performante.

Je recommande donc d’utiliser la carte Tâche IA pour traiter des informations (par exemple, détecter l’intention de l’utilisateur ou analyser une entrée). Mais si vous souhaitez simplement générer du texte, utilisez plutôt la carte Générer du texte IA (par exemple, pour développer une réponse de KB ou générer une question de façon créative).

Pour approfondir les différences entre la carte Tâche IA et la carte Générer du texte IA, en savoir plus ici.

Traductions

Si votre bot doit gérer un grand volume de conversations multilingues, envisagez d’intégrer des hooks avec des services de traduction externes pour une solution plus économique.

Vous trouverez plus d’informations sur les hooks ici.

Conclusion

Avec ces stratégies et conseils, vous pourrez optimiser vos dépenses en IA sur Botpress. Comprendre l’impact des différentes tâches et choisir les méthodes les plus efficaces pour vos besoins vous permettra de réduire vos coûts sans sacrifier les performances.

Notre équipe est là pour vous aider à explorer ces options et garantir que votre bot offre la meilleure expérience possible à vos utilisateurs, tout en optimisant les coûts. Consultez notre page Tarifs pour plus d’informations ou rejoignez notre serveur Discord pour obtenir de l’aide.

Annexe

Comment éviter la mise en cache

Si vous souhaitez contourner la mise en cache afin d’obtenir des résultats en temps réel, vous pouvez choisir l’une des options suivantes :

- Pour empêcher la mise en cache de façon permanente : ajoutez `And discard:{{Date.now()}}` dans toutes vos cartes liées à l’IA (par exemple, dans les prompts de tâches IA, dans le contexte de la base de connaissances, etc.).

- Pour empêcher temporairement la mise en cache : publiez votre bot et testez-le dans une fenêtre de navigation privée.

Formations recommandées

- ChatGPT Prompt Engineering for Developers (même si le titre s’adresse aux développeurs, les non-développeurs en profiteront aussi!)

- Créer des systèmes avec l’API ChatGPT

.webp)