- La alucinación de IA ocurre cuando los modelos generan con confianza información falsa o inventada, causada por mala calidad de datos, sobreajuste o indicaciones ambiguas.

- Las alucinaciones pueden ir desde errores fácticos hasta contenido inventado y pueden dañar la confianza, costar miles de millones a las empresas o difundir desinformación perjudicial.

- Las principales medidas de prevención incluyen elegir plataformas de IA confiables, añadir generación aumentada por recuperación (RAG), crear indicaciones precisas e incluir supervisión humana.

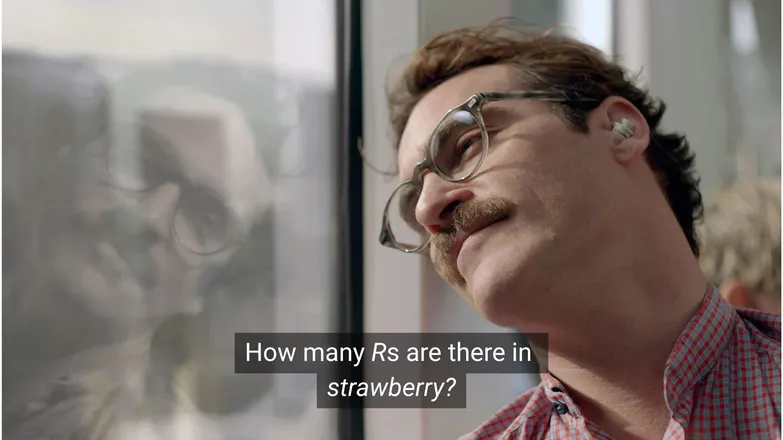

¿Crees que Joaquin Phoenix se habría enamorado de Scarlett Johansson si le hubiera preguntado cuántas R hay en strawberry? Si usas LinkedIn, sabes que la respuesta es 3. (O, bueno, si sabes leer.)

Pero para los chatbots de IA, no siempre es tan sencillo.

Probablemente hayas visto a personas burlándose de lo absurdo de las alucinaciones de IA. Y, siendo justos, que un modelo de IA con supuestos conocimientos infinitos, razonamiento casi humano y ejecución de tareas ultrarrápida falle en un problema de matemáticas de nivel infantil es, bueno, bastante absurdo.

Pero detrás de la diversión hay una realidad más seria — y potencialmente peligrosa.

En este artículo, hablaré sobre las alucinaciones de IA: qué son, qué las causa, por qué importan y qué medidas puedes tomar para prevenirlas.

¿Qué es la alucinación de IA?

La alucinación de IA ocurre cuando un modelo de IA presenta información que es inexacta, engañosa o completamente inventada. Esta información falsa puede parecer creíble y, en muchos casos, pasar desapercibida.

Debido a la amplia adopción de los LLM, las alucinaciones suelen mencionarse en el contexto de modelos generativos de texto. En realidad, representan un riesgo para cualquier aplicación de IA Generativa.

¿Qué causa la alucinación en la IA?

La alucinación de IA ocurre cuando los modelos aprenden patrones erróneos.

Patrones, en el contexto de la IA, se refiere a la capacidad de usar ejemplos de entrenamiento individuales para generalizar sobre datos no vistos. Esto puede ser una serie de palabras para formar la continuación de un texto, o la distribución de píxeles de una imagen que corresponde a un perro.

En el caso de la alucinación de LLM, el modelo considera que una serie de palabras es la continuación más probable a la indicación del usuario, aunque sea falsa.

Esto puede deberse a una o varias de las siguientes razones:

Datos de entrenamiento de baja calidad

ChatGPT y modelos LLM similares se entrenan con grandes cantidades de datos. Estos datos, por abundantes que sean, son imperfectos debido a:

- Faltas en ciertos temas

- Reflejo de prejuicios del mundo real

- Desinformación deliberada o sátira no identificada

- Sesgo, es decir, datos desequilibrados o “inclinados”.

Imagina un escenario donde el modelo fue entrenado con información sobre todos los dioses griegos menos uno.

Su capacidad para establecer conexiones estadísticas entre temas relacionados con la mitología griega—amor, ética, traición—podría hacer que invente una mitología que considere “probable” según su modelo estadístico.

Esto también se observa en la generación de imágenes, donde la mayoría de las indicaciones para sujetos femeninos producen imágenes hipersexualizadas. El sesgo hacia un tipo particular de representación condiciona los tipos de imágenes que se generan.

La ortografía de strawberry probablemente ha aparecido en los datos de entrenamiento en el contexto de una discusión sobre la doble R, un dolor de cabeza habitual para quienes no son nativos en inglés. En este caso, es probable que hayan aparecido el número 2 o la palabra “double” en relación con la ortografía de la palabra.

Por otro lado, es poco probable que los datos mencionen que tiene 3 R.

El resultado es absurdo porque la indicación es: ¿en qué circunstancia alguien escribiría una palabra y luego preguntaría cómo se escribe?

Arquitectura del modelo y método de generación

Los modelos se construyen a partir de arquitecturas de redes neuronales increíblemente complejas. Pequeñas variaciones afectan la forma en que los modelos interactúan con sus datos de entrenamiento y las indicaciones de entrada. La capacidad de un modelo para mitigar la alucinación mejora de forma incremental mediante investigación y pruebas rigurosas.

A esto se suma cómo se implementa la generación. Palabra por palabra (en realidad word-piece), los modelos predicen la palabra más probable que sigue. Así que:

“The quick brown fox jumps over the lazy ___.”

Determinará que la siguiente palabra más probable es “dog”. Pero hay otras opciones posibles. Y generar solo en base a la palabra más probable produce resultados poco interesantes y predecibles.

Eso significa que hay que emplear métodos de muestreo creativos para que las respuestas sean interesantes pero coherentes. Al hacerlo, a veces se pierde la veracidad.

Sobreajuste

El sobreajuste ocurre cuando el modelo se entrena para predecir los datos tan de cerca que no logra generalizar a nuevas entradas.

Así que, si yo fuera un modelo (como dice mi mamá que debería ser), estaría bien entrenado si reconociera a los perros como:

Peludos, con orejas caídas, juguetones y una pequeña nariz marrón.

Pero estaría sobreajustado si solo los reconociera como:

Con un punto marrón bajo la barbilla, responde al nombre de “Frank” y destrozó mi buen par de Nikes.

En el contexto de un LLM, normalmente se ve como repetir información vista en los datos de entrenamiento, en vez de admitir cuando no sabe la respuesta.

Por ejemplo, si le preguntas a un chatbot por la política de devoluciones de una empresa. Si no la conoce, debería decírtelo. Pero si está sobreajustado, podría devolverte la política de una empresa similar.

Mala formulación de indicaciones

Las empresas están emitiendo certificados en ingeniería de indicaciones sabiendo que la IA solo es tan buena como sus entradas.

Una buena indicación está formulada con precisión, evita términos demasiado específicos y proporciona todo el contexto necesario.

Esto se debe a que la alucinación ocurre en el límite de muchas salidas de baja probabilidad.

Por ejemplo, si preguntas “¿cuál es la trama de shark girl?” Ahora, una persona pensaría “hmm, shark girl.” En el mundo de la estadística, las posibilidades son:

- The Adventures of Sharkboy and Lavagirl – una película infantil bastante popular de 2005 con un nombre parecido.

- Un thriller/terror de 2024 llamado Shark Girl – menos conocido pero más reciente y preciso.

- Un libro infantil con el mismo nombre publicado a principios de este año – que el modelo puede o no haber indexado.

Ninguna de estas opciones es la obvia, lo que resulta en una distribución de probabilidad “más plana” con menos inclinación hacia un tema o narrativa. Una indicación más efectiva proporcionaría contexto, es decir, aclararía a cuál ejemplo se refiere el usuario.

Esta mezcla de ambigüedad y relevancia tangencial puede producir una respuesta que sea justo eso: una trama genérica inventada sobre una historia de tiburones.

Reducir la probabilidad de alucinaciones es reducir la incertidumbre.

Tipos de alucinaciones de IA

Hasta ahora he hablado de las alucinaciones de forma general. La realidad es que afecta casi todos los aspectos de la IA. Sin embargo, para mayor claridad, es mejor considerar las diferentes categorías.

Errores fácticos

Aquí encaja el ejemplo de la fresa. Hay errores en los detalles de afirmaciones que por lo demás son fácticas. Esto puede incluir el año en que ocurrió un evento, la capital de un país o cifras de una estadística.

Detalles mínimos en una respuesta por lo demás correcta pueden ser especialmente problemáticos, sobre todo en datos que las personas no suelen recordar, como cifras exactas.

Contenido inventado

En 2023, Bard de Google afirmó falsamente que el telescopio James Webb se usó para tomar las primeras fotos de exoplanetas. No fue una cuestión de imprecisión técnica, simplemente era falso.

A veces son afirmaciones audaces como la anterior, pero más a menudo aparecen como enlaces que no llevan a ningún lado, o nombres inventados de librerías y funciones de código.

Cabe destacar que la línea entre errores factuales y contenido inventado no siempre es clara.

Supongamos que hablamos de un investigador. Si citamos uno de sus artículos pero nos equivocamos de año, es un error factual. Si nos equivocamos de nombre, ¿entonces qué? ¿Y si fallamos en el nombre y el año?

Desinformación

Esto puede encajar en cualquiera de las dos categorías anteriores, pero se refiere a información falsa donde la fuente es más transparente.

La IA de Google recomendando pizza con pegamento y comer piedras es un gran ejemplo de esto; el material original es claramente satírico y generalmente inofensivo—comentarios de Reddit escritos por The Onion—pero el entrenamiento del modelo no lo tuvo en cuenta.

Riesgos de las alucinaciones de IA

1. Pérdida de confianza

Nos gusta poder delegar tareas a la IA, pero no a costa de nuestra confianza.

El reciente error de Cursor AI—un bot de atención al cliente inventando una política restrictiva—ha llevado a muchos usuarios a cancelar sus suscripciones y cuestionar su fiabilidad.

2. Coste

La IA ocupa un lugar central en muchas empresas y, aunque eso es positivo, un error puede salir caro.

La alucinación de Google sobre James Webb provocó una caída de 100 mil millones de dólares en el valor de las acciones de Alphabet en pocas horas. Y eso sin contar el coste de volver a entrenar los modelos.

3. Desinformación perjudicial

Nos reímos de lo absurdo de la pizza con pegamento, pero ¿qué pasa con dosis médicas incorrectas?

Seré el primero en cambiar la lectura de advertencias en letra pequeña por una respuesta rápida de IA. Pero, ¿y si está equivocada? Casi seguro que no tendrá en cuenta todas las posibles condiciones médicas.

3. Seguridad y malware

Como se mencionó, la IA suele inventar nombres de librerías de código. Si intentas instalar una librería que no existe, no pasa nada.

Ahora imagina que un hacker introduce malware en un código y lo sube usando el nombre de una librería que la IA suele inventar. Instalas la librería y 💨puf💨: te han hackeado.

Esto existe y se llama slopsquatting.

Más allá del nombre desagradable, nunca está de más ser crítico con lo que instalas y verificar cualquier nombre de librería que suene exótico.

Pasos para prevenir alucinaciones de IA

Si no entrenas los modelos, poco puedes hacer en cuanto a datos y arquitectura.

La buena noticia es que aún puedes tomar precauciones, y pueden marcar la diferencia para evitar alucinaciones en la IA.

Elige un modelo y una plataforma en la que confíes

No estás solo. Las empresas de IA tienen todo el interés en mantener la confianza, y eso significa evitar alucinaciones.

Dependiendo de lo que hagas con la IA, casi siempre tienes varias opciones, y una buena plataforma de IA lo facilita. Estas plataformas deben ser transparentes sobre cómo mitigan las alucinaciones.

Usa RAG (Generación Aumentada por Recuperación)

No hagas que el modelo dependa de su propio conocimiento. Equipar tu modelo con RAG deja claro que la información está disponible y dónde encontrarla.

Lo ideal es usar la IA en una plataforma con instrucciones sencillas sobre cómo implementar RAG de forma efectiva.

Agrega instrucciones detalladas

Seguro que lo has oído mil veces: si entra basura, sale basura.

“Responde a la pregunta del usuario” no garantiza el éxito. Sin embargo, algo como:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.ayudará a mantener a tu agente bajo control. Instrucciones claras y límites firmes son tu mejor defensa contra un agente descontrolado.

Verificación humana

En cuanto a la escalada, contar con una persona lista para revisar, evaluar y corregir los fallos de la IA.

La posibilidad de escalar o verificar conversaciones a posteriori te permite identificar qué funciona y qué está en riesgo de alucinación. Human-in-the-loop—supervisión humana de los flujos de trabajo impulsados por IA—es imprescindible aquí.

Usa IA sin alucinaciones hoy mismo

La incertidumbre sobre la fiabilidad de la IA puede estar frenando la transformación digital de muchas empresas.

Las capacidades RAG de Botpress, la integración human-in-the-loop y sistemas de seguridad robustos hacen que la IA sea segura y confiable. Tu agente trabaja para ti, no al revés.

Empieza a construir hoy. Es gratis.

Preguntas frecuentes

1. ¿Cómo puedo saber si una respuesta de IA es una alucinación sin tener conocimientos previos sobre el tema?

Para saber si una respuesta de IA es una alucinación sin conocimientos previos, busca señales como afirmaciones muy específicas, lenguaje excesivamente seguro, o nombres, estadísticas o citas que no puedan verificarse de forma independiente. Si tienes dudas, pide a la IA que cite sus fuentes o contrasta con referencias externas confiables.

2. ¿Qué tan comunes son las alucinaciones de IA en los grandes modelos de lenguaje (LLM)?

Las alucinaciones de IA son frecuentes en los grandes modelos de lenguaje porque generan texto en base a probabilidades, no a verificación de hechos. Incluso modelos avanzados como GPT-4o y Claude 3.5 pueden producir respuestas inexactas, especialmente sobre temas poco comunes o con poca información contextual.

3. ¿Pueden ocurrir alucinaciones en modelos de IA que no son de texto, como los generadores de imágenes?

Sí, las alucinaciones también ocurren en modelos de generación de imágenes, a menudo como elementos poco realistas o sin sentido en el resultado—como extremidades extra o representaciones culturales incorrectas—debido a sesgos o carencias en los datos de entrenamiento.

4. ¿Las alucinaciones son más comunes en ciertos idiomas o culturas debido a sesgos en los datos de entrenamiento?

Las alucinaciones son más frecuentes en idiomas poco representados o contextos culturales no occidentales porque la mayoría de los LLM se entrenan principalmente con datos en inglés y centrados en Occidente, lo que lleva a respuestas menos matizadas culturalmente.

5. ¿Qué industrias están más expuestas a las consecuencias de las alucinaciones de IA?

Industrias como la salud, finanzas, derecho y atención al cliente son las más expuestas a las alucinaciones de IA, ya que respuestas inexactas en estos campos pueden causar incumplimientos normativos, pérdidas económicas, errores legales o dañar la confianza del usuario y la reputación de la marca.

.webp)