- تحدث الهلوسة في الذكاء الاصطناعي عندما تنتج النماذج معلومات خاطئة أو مختلقة بثقة، ويكون ذلك نتيجة ضعف جودة البيانات، أو الإفراط في التخصيص، أو الغموض في التعليمات.

- تتراوح الهلوسات بين أخطاء واقعية ومحتوى مختلق، وقد تؤدي إلى فقدان الثقة، وتكبد الشركات خسائر بمليارات الدولارات، أو نشر معلومات مضللة وضارة.

- تشمل الخطوات الأساسية للوقاية اختيار منصات ذكاء اصطناعي موثوقة، وإضافة توليد معزز بالاسترجاع (RAG)، وصياغة تعليمات دقيقة، وإشراك إشراف بشري.

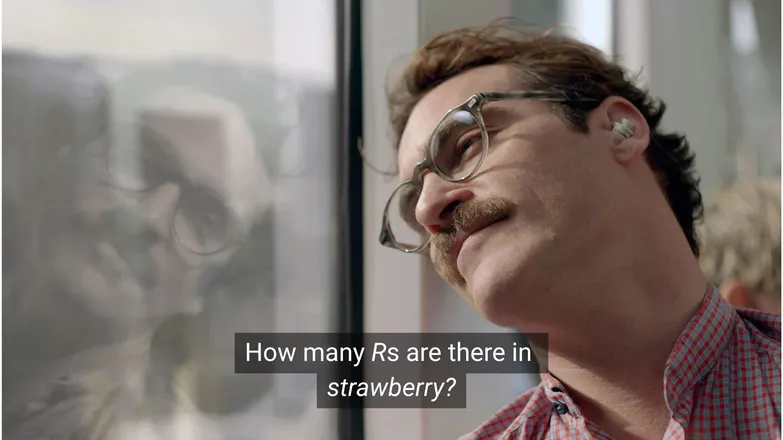

هل تعتقد أن خواكين فينيكس كان سيقع في حب سكارليت جوهانسون لو سألها عن عدد حروف R في كلمة strawberry؟ إذا كنت على LinkedIn، فأنت تعلم أن الإجابة هي 3. (أو، كما تعلم، إذا كنت تستطيع القراءة.)

لكن بالنسبة لـ روبوتات الدردشة الذكية، الأمر ليس بهذه البساطة دائمًا.

ربما شاهدت أشخاصًا يسخرون من غرابة الهلوسات في الذكاء الاصطناعي. وللإنصاف، فإن فشل نموذج ذكاء اصطناعي يبدو أنه يمتلك معرفة لا نهائية، وقدرات تفكير بشرية، وسرعة تنفيذ مذهلة في حل مسألة رياضية بمستوى رياض الأطفال هو أمر غريب بالفعل.

لكن خلف هذه الطرافة تكمن حقيقة أكثر جدية — وربما خفية —.

في هذا المقال، سأتحدث عن هلوسات الذكاء الاصطناعي: ما هي، وما أسبابها، ولماذا هي مهمة، وما الإجراءات التي يمكنك اتخاذها للحد منها.

ما هي هلوسة الذكاء الاصطناعي؟

هلوسة الذكاء الاصطناعي هي عندما يقدم النموذج معلومات غير دقيقة أو مضللة أو مختلقة بالكامل. قد تبدو هذه المعلومات الخاطئة مقنعة، وغالبًا ما تمر دون ملاحظة.

نظرًا للاستخدام الواسع لنماذج اللغة الكبيرة، غالبًا ما يُشار إلى الهلوسات في سياق نماذج النصوص التوليدية. في الواقع، تشكل خطرًا في أي تطبيق للذكاء الاصطناعي التوليدي.

ما الذي يسبب الهلوسة في الذكاء الاصطناعي؟

تحدث هلوسة الذكاء الاصطناعي عندما تتعلم النماذج أنماطًا خاطئة.

تشير الأنماط في سياق الذكاء الاصطناعي إلى قدرة النموذج على استخدام أمثلة التدريب الفردية من أجل التعميم على بيانات لم يرها من قبل. قد يكون ذلك سلسلة من الكلمات لتشكيل استكمال نص، أو توزيع بكسلات صورة تشير إلى كلب.

في حالة هلوسة نماذج اللغة الكبيرة، يرى النموذج أن سلسلة من الكلمات هي الأكثر احتمالاً كاستجابة لتعليمات المستخدم، رغم أنها خاطئة.

وقد يكون ذلك بسبب واحد أو أكثر من الأسباب التالية:

بيانات تدريب منخفضة الجودة

يتم تدريب ChatGPT ونماذج اللغة الكبيرة المشابهة على كميات ضخمة من البيانات. هذه البيانات، رغم كثرتها، ليست مثالية بسبب:

- وجود فجوات في بعض المواضيع

- تعكس تحيزات العالم الحقيقي

- معلومات مضللة متعمدة أو سخرية غير موضحة

- تحيز، أي عدم توازن أو بيانات "منحازة".

تخيل سيناريو تم فيه تدريب النموذج على معلومات عن جميع الآلهة اليونانية باستثناء واحد.

قدرة النموذج على إيجاد روابط إحصائية بين مواضيع شبيهة بالأساطير اليونانية — مثل الحب، والأخلاق، والخيانة — قد تدفعه إلى اختلاق أسطورة جديدة يراها "محتملة" بناءً على نموذجه الإحصائي.

يظهر ذلك أيضًا في توليد الصور، حيث تؤدي معظم التعليمات المتعلقة بموضوع أنثوي إلى صور مفرطة في التمثيل الجنسي. إن التحيز نحو نوع معين من التصوير يؤثر على أنواع الصور الناتجة.

من المرجح أن تهجئة كلمة strawberry ظهرت في بيانات التدريب في سياق مناقشة وجود حرف R المزدوج، وهي نقطة صعبة شهيرة لغير الناطقين بالإنجليزية. في هذه الحالة، من المحتمل أن يظهر الرقم 2 أو كلمة “double” عند الحديث عن تهجئة الكلمة.

من ناحية أخرى، من غير المرجح أن تشير البيانات إلى وجود 3 حروف R فيها.

الناتج يبدو غريبًا لأن التعليمات نفسها: في أي ظرف قد يكتب شخص كلمة ثم يسأل عن كيفية تهجئتها؟

بنية النموذج وطريقة التوليد

تُبنى النماذج من شبكات عصبية ذات بنى معمارية معقدة للغاية. تؤثر التغييرات الطفيفة على طريقة تفاعل النماذج مع بيانات التدريب والمطالبات المدخلة. قدرة النموذج على التقليل من الهلوسة تخضع لـتحسين تدريجي من خلال البحث والاختبار الدقيقين.

وفوق ذلك، هناك كيفية تنفيذ التوليد. كلمة بكلمة (في الواقع جزء الكلمة)، تتنبأ النماذج بالكلمة الأكثر احتمالاً أن تلي. إذًا:

“الثعلب البني السريع يقفز فوق الكلب الكسول ___.”

سيحدد النموذج أن الكلمة التالية الأكثر احتمالاً هي “كلب”. لكن كلمات أخرى ممكنة أيضًا. والتوليد بناءً فقط على اختيار الكلمة الأكثر احتمالاً ينتج عنه إجابات مملة ومتوقعة.

وهذا يعني أنه يجب استخدام طرق توليد إبداعية للحفاظ على الردود مثيرة ومنطقية في الوقت نفسه. وأثناء ذلك، قد يتم تجاهل الدقة أحيانًا.

الإفراط في التخصيص (Overfitting)

الإفراط في التخصيص هو عندما يتم تدريب النموذج على توقع البيانات بدقة شديدة لدرجة أنه يفشل في التعميم على مدخلات جديدة.

فلو كنت نموذجًا (كما تقول أمي أنه يجب أن أكون)، فسأكون مدربًا بشكل صحيح إذا تعرفت على الكلاب بأنها:

مشعرة، لها آذان متدلية، مرحة، وأنف بني صغير.

أما إذا كنت مفرط التخصيص فسأتعرف عليها فقط إذا كانت:

لديها نقطة بنية تحت الذقن، وتستجيب لاسم “فرانك”، وقد مزقت حذائي الجيد من نايكي.

في سياق نموذج لغة كبير، يظهر ذلك غالبًا في تكرار المعلومات التي ظهرت في بيانات التدريب، بدلاً من الامتناع عن الإجابة عندما لا يعرف.

مثلاً إذا سألت روبوت دردشة عن سياسة الإرجاع لشركة ما، وإذا لم يكن يعرف، يجب أن يخبرك بذلك. أما إذا كان مفرط التخصيص، فقد يعطيك سياسة شركة مشابهة.

تعليمات سيئة (Poor Prompting)

تقوم الشركات بإصدار شهادات في هندسة التعليمات مع العلم أن الذكاء الاصطناعي لا يكون أفضل من مدخلاته.

التعليمات الجيدة تكون مصاغة بدقة، وتتجنب المصطلحات المتخصصة، وتوفر كل السياق اللازم.

وذلك لأن الهلوسة تحدث غالبًا عند أطراف المخرجات ذات الاحتمالية المنخفضة.

مثلاً إذا سألت: “ما قصة فيلم shark girl؟” الآن، الإنسان سيفكر: “هاه، shark girl.” في عالم الإحصاء، الاحتمالات هي:

- The Adventures of Sharkboy and Lavagirl – فيلم أطفال شهير من 2005 باسم مشابه.

- فيلم رعب/إثارة صدر عام 2024 باسم Shark Girl – أقل شهرة لكنه أحدث وأكثر دقة.

- كتاب أطفال بنفس الاسم صدر في وقت سابق من هذا العام — قد يكون النموذج قد فهرسه أو لا.

لا يوجد خيار واضح بينها، مما يؤدي إلى توزيع احتمالية “مسطح” مع التزام أقل بموضوع أو سرد معين. ستكون التعليمات الأكثر فعالية هي التي تقدم سياقًا وتوضح أي مثال يقصده المستخدم.

هذا المزيج من الغموض والارتباطات الجانبية قد ينتج عنه إجابة مختلقة لقصة عامة تتعلق بأسماك القرش.

تقليل احتمالية الهلوسة يتعلق بتقليل عدم اليقين.

أنواع هلوسات الذكاء الاصطناعي

حتى الآن تحدثت عن الهلوسات بشكل عام. في الواقع، هي تمس تقريبًا جميع جوانب الذكاء الاصطناعي. لكن من أجل الوضوح، من الأفضل النظر إلى الفئات المختلفة.

أخطاء واقعية

هنا يندرج مثال الفراولة. هناك أخطاء في تفاصيل عبارات صحيحة في مجملها. قد تشمل ذلك سنة وقوع حدث معين، أو عاصمة دولة، أو أرقام إحصائية.

التفاصيل الدقيقة في إجابة جيدة عمومًا قد تكون خادعة بشكل خاص، خاصة عندما يتعلق الأمر بتفاصيل لا يتذكرها البشر غالبًا، مثل الأرقام الدقيقة.

محتوى مختلق

في عام 2023، ادعى Bard من Google بشكل خاطئ أن تلسكوب جيمس ويب استخدم لالتقاط أول صور لكواكب خارجية. لم تكن هذه مجرد أخطاء تقنية – بل كانت معلومة خاطئة تمامًا.

قد تكون هذه ادعاءات جريئة كما في المثال أعلاه، لكنها غالبًا ما تظهر على شكل روابط لا تؤدي إلى أي مكان، أو مكتبات وأوامر برمجية مختلقة.

من الجدير بالذكر أن الخط الفاصل بين الأخطاء الواقعية والمحتوى الملفق ليس واضحًا دائمًا.

لنفترض أننا نناقش باحثًا ما. إذا ذكرنا ورقة علمية له لكن أخطأنا في سنة النشر فهذا خطأ واقعي. أما إذا أخطأنا في الاسم، فماذا يكون ذلك؟ وماذا لو أخطأنا في الاسم والسنة معًا؟

المعلومات المضللة

يمكن أن تندرج هذه تحت أي من الفئتين السابقتين، لكنها تشير إلى معلومات خاطئة يكون مصدرها أكثر وضوحًا.

من الأمثلة الشهيرة على ذلك توصية Google AI بوضع الغراء على البيتزا وأكل الصخور؛ فالمصدر هنا ساخر وواضح – تعليقات على Reddit كتبها The Onion، لكن تدريب النموذج لم يأخذ ذلك في الحسبان.

مخاطر هلوسة الذكاء الاصطناعي

1. فقدان الثقة

نحن نقدر حرية تفويض المهام للذكاء الاصطناعي، لكن ليس على حساب ثقتنا به.

حادثة Cursor AI الأخيرة – حيث اخترع روبوت خدمة العملاء سياسة تقييدية – دفعت العديد من المستخدمين إلى إلغاء اشتراكاتهم والتشكيك في موثوقيته.

2. التكلفة

أصبح الذكاء الاصطناعي في صدارة العديد من الأعمال، ورغم أن ذلك أمر جيد، إلا أن أي خطأ قد يكون مكلفًا.

تسببت هلوسة Google حول تلسكوب جيمس ويب في انخفاض بقيمة 100 مليار دولار في أسهم Alphabet خلال ساعات قليلة. وذلك قبل احتساب تكلفة إعادة تدريب النماذج.

3. المعلومات المضللة الضارة

قد نضحك على غرابة فكرة بيتزا الغراء، لكن ماذا عن جرعات طبية مضللة؟

سأكون أول من يفضل إجابة سريعة من الذكاء الاصطناعي على قراءة التحذيرات الدقيقة. لكن ماذا لو كانت الإجابة خاطئة؟ من المؤكد أنها لن تغطي جميع الحالات الطبية الممكنة.

3. الأمان والبرمجيات الخبيثة

كما ذُكر سابقًا، غالبًا ما يخترع الذكاء الاصطناعي أسماء لمكتبات برمجية. وعندما تحاول تثبيت مكتبة غير موجودة، لا يحدث شيء.

تخيل الآن أن أحد المخترقين يزرع برمجية خبيثة في كود ويرفعها باسم مكتبة شائعة الهلوسة. تقوم بتثبيت المكتبة، و💨فجأة💨: اختُرِقت.

هذا الأمر موجود بالفعل، ويُسمى slopsquatting.

بعيدًا عن الاسم الغريب، من الأفضل دائمًا أن تكون حذرًا فيما تقوم بتثبيته، وأن تتحقق من أسماء المكتبات غير المألوفة.

خطوات للحد من هلوسة الذكاء الاصطناعي

إذا لم تكن تدرب النماذج بنفسك، فليس هناك الكثير مما يمكنك فعله على مستوى البيانات أو البنية.

الخبر السار هو أنه لا تزال هناك احتياطات يمكنك اتخاذها، ويمكن أن تحدث فرقًا كبيرًا في تقديم ذكاء اصطناعي خالٍ من الهلوسة.

اختر نموذجًا ومنصة يمكنك الوثوق بها

لست وحدك في هذا. لدى شركات الذكاء الاصطناعي مصلحة كبيرة في الحفاظ على الثقة، وهذا يعني عدم وجود هلوسات.

اعتمادًا على ما تفعله بالذكاء الاصطناعي، غالبًا ما يكون لديك عدة خيارات، والمنصة المناسبة للذكاء الاصطناعي تجعل ذلك متاحًا. يجب أن تكون هذه المنصات شفافة بشأن كيفية الحد من الهلوسة.

استخدم RAG (التوليد المعزز بالاسترجاع)

لا تجعل النموذج يعتمد فقط على معرفته الذاتية. تزويد النموذج بـ RAG يوضح أن المعلومات متاحة وأين يمكن العثور عليها.

من الأفضل تشغيل الذكاء الاصطناعي على منصة تقدم تعليمات واضحة حول كيفية تنفيذ RAG بشكل فعال.

أضف تعليمات دقيقة

إذا سمعت هذه العبارة مرة فقد سمعتها ألف مرة: مدخلات سيئة تعني مخرجات سيئة.

"أجب عن سؤال المستخدم" لن يضمن النجاح. لكن تعليمات مثل:

# Instructions

Please refer exclusively to the FAQ document. If the answer does not appear there:

* Politely inform the user that the information is unavailable.

* Offer to escalate the conversation to a human agent.ستحافظ على انضباط وكيلك. التوجيه الواضح مع ضوابط صارمة هو أفضل وسيلة للدفاع ضد تصرفات الوكيل غير المتوقعة.

التحقق البشري

في سياق التصعيد، وجود شخص مستعد لفحص وتقييم ومعالجة أوجه القصور في الذكاء الاصطناعي.

إمكانية التصعيد أو التحقق اللاحق للمحادثات تتيح لك معرفة ما الذي يعمل وما هو معرض للهلوسة. البشر في الحلقة – الإشراف البشري على سير العمل المدعوم بالذكاء الاصطناعي – هو أمر ضروري هنا.

استخدم ذكاء اصطناعي خالٍ من الهلوسة اليوم

قد تكون الشكوك حول موثوقية الذكاء الاصطناعي سببًا في تأخر التحول الرقمي لدى بعض الشركات.

قدرات RAG في Botpress، وتكامل البشر في الحلقة، وأنظمة الأمان الشاملة تجعل الذكاء الاصطناعي آمنًا وموثوقًا. وكيلك يعمل لصالحك، وليس العكس.

ابدأ البناء اليوم. إنه مجاني.

الأسئلة الشائعة

1. كيف يمكنني معرفة ما إذا كانت إجابة الذكاء الاصطناعي هلوسة دون معرفة مسبقة بالموضوع؟

لمعرفة ما إذا كانت إجابة الذكاء الاصطناعي هلوسة دون معرفة مسبقة، ابحث عن علامات مثل الادعاءات المحددة جدًا، أو لغة واثقة بشكل مبالغ فيه، أو أسماء وإحصائيات أو مراجع لا يمكن التحقق منها بشكل مستقل. عند الشك، اطلب من الذكاء الاصطناعي ذكر مصادره أو تحقق من الإجابة عبر مصادر خارجية موثوقة.

2. ما مدى شيوع هلوسة الذكاء الاصطناعي في النماذج اللغوية الكبيرة (LLMs)؟

هلوسة الذكاء الاصطناعي شائعة في النماذج اللغوية الكبيرة لأنها تولد النصوص بناءً على الاحتمالات وليس على التحقق من الحقائق. حتى النماذج المتقدمة مثل GPT-4o وClaude 3.5 قد تنتج مخرجات غير دقيقة، خاصة عند السؤال عن مواضيع متخصصة أو في سياقات قليلة المعلومات.

3. هل يمكن أن تحدث الهلوسة في نماذج الذكاء الاصطناعي غير النصية مثل مولدات الصور؟

نعم، تحدث الهلوسة أيضًا في نماذج توليد الصور، وغالبًا ما تظهر على شكل عناصر غير واقعية أو غير منطقية في النتائج – مثل وجود أطراف إضافية أو تمثيلات ثقافية غير صحيحة – بسبب التحيزات أو الثغرات في بيانات التدريب.

4. هل الهلوسة أكثر شيوعًا في لغات أو ثقافات معينة بسبب تحيزات بيانات التدريب؟

تكون الهلوسة أكثر شيوعًا في اللغات غير الممثلة بشكل كافٍ أو في السياقات الثقافية غير الغربية، لأن معظم النماذج اللغوية الكبيرة تُدرَّب أساسًا على بيانات باللغة الإنجليزية وتركز على الثقافة الغربية، مما يؤدي إلى استجابات أقل دقة ثقافيًا.

5. ما هي القطاعات الأكثر عرضة لمخاطر هلوسة الذكاء الاصطناعي؟

قطاعات مثل الرعاية الصحية، والمالية، والقانون، وخدمة العملاء هي الأكثر عرضة لمخاطر هلوسة الذكاء الاصطناعي، حيث يمكن أن تؤدي المخرجات غير الدقيقة في هذه المجالات إلى انتهاكات تنظيمية، أو خسائر مالية، أو أخطاء قانونية، أو الإضرار بثقة المستخدم وسمعة العلامة التجارية.

.webp)